All Posts

국내 2,200개 상장사 포함 전세계 42,000개 상장기업에 대한 리스크 정보 제공 기업 부도 확률, 거시지표 민감도, 신용 등급, 채권 등급 등 분석 정보 포함 신청 기업에게 심사 과정 거쳐 30일 무료 체험 기회 제공 SAS코리아는 지난 10월 19일 국내 금융 및 투자사 임직원들을 모시고 급변하는 경제 환경에서 기업의 리스크

En el vertiginoso mundo de la tecnología, las tendencias emergentes marcan el camino hacia el futuro. Una de las proyecciones más intrigantes que Gartner presenta con miras al 2024 es el concepto de "IA Trust" (Confianza en la Inteligencia Artificial). Se trata de una de las temáticas más importantes incluidas

At SAS, a world-class workplace is an important part of our employee experience, and our Cary Headquarters is no exception. From awe-inspiring buildings to incredible sculptures, every element is designed to delight and inspire. Ready for a tour through photos? Let's start at the beginning. In the early days, our

Accomplish something great with SAS software? Enter the 2024 SAS Customer Recognition Awards contest through Jan. 19.

As millions of people party and eat their way through the season of overindulgence, they should feel confident that indigestion and a few extra pounds should be the only downsides to their feasting. Thanks to countless hours of work behind the scenes by food inspectors and public health officials, diners

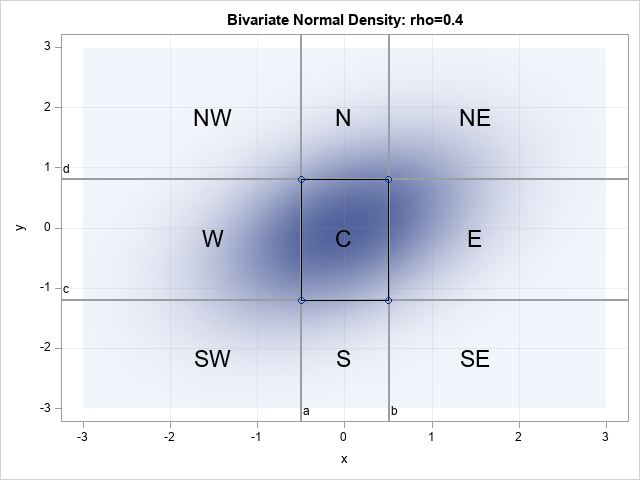

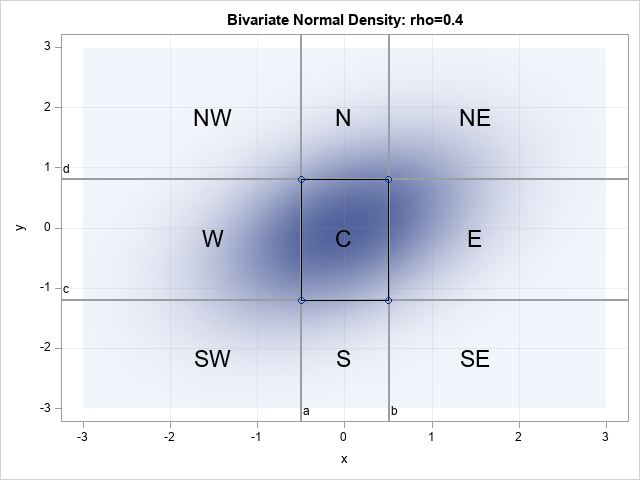

A previous article discussed how to compute probabilities for the bivariate standard normal distribution. The standard bivariate normal distribution with correlation ρ is denoted BVN(0,ρ). For any point (x,y), you can use the PROBBNRM function in SAS to compute the probability that the random variables (X,Y) ~ BVN(0,ρ) is observed

Na przestrzeni lat krajobraz oszustw przeszedł wiele transformacji, a techniki stosowane przez oszustów ewoluowały. Niektóre z trendów wykorzystywanych przez oszustów obejmują podszywanie się między innymi pod kurierów, banki, firmy energetyczne, a nawet firmy loteryjne. Okazja czyni złodzieja W czasie pandemii dużą popularność zyskał pet scam, czyli schemat opierający się na

Some organizations need advanced analytics that is customized, configured and managed off-site. That’s where the SAS-managed offerings come in. Ever wondered what it takes to get a SAS managed application services (MAS) project implemented and supported continuously? That’s where Jenny Welsh comes in. She’s the Senior Director of Cloud Customer Experience. Jenny and her teams

1.背景 データ管理と分析の世界では、効率的かつ迅速なデータの転送と書き込みは極めて重要です。特に大規模なデータウェアハウスサービスを利用する際には、このプロセスの最適化が不可欠です。Azure Synapse Analyticsは、そのようなサービスの一つとして注目を集めており、SAS Viyaを使用する多くの企業やデータアナリストも、より効率的なデータハンドリングを追求しています。 SAS ViyaのユーザーはSAS/ACCESS to Microsoft SQL Serverを使用してAzure Synapseにデータを転送および書き込む際に、より高いデータ書き込み効率と転送速度を求めるのは当然です。データ処理能力をさらに強化し、書き込み効率を高めるために、SAS Access to SynapseのBulkLoad機能は非常に優れた選択肢です。BulkLoad機能はデータの書き込み速度を大幅に向上させるだけでなく、Azure Data Lake Storage Gen 2(以下、ADLS2と称する)を利用して、安定かつ安全なデータストレージおよび転送環境を提供します。 ただし、BulkLoad機能を使用する際にはADLS2の設定と構成が関わってくるため、構成および使用のプロセスが複雑に感じられたり、疑問が生じたりすることがあります。このブログの目的は、管理者およびユーザーに対して、明確なステップバイステップの設定プロセスを提供し、構成の過程で見落とされがちなキーポイントを強調することで、設定時の参考になるようにすることです。 以下は本記事内容の一覧です。読者は以下のリンクをで興味のあるセクションに直接ジャンプすることができます。 2.Bulkload機能について 3.BULKLOAD機能を利用するためのAzure側で必要なサービスの作成 3-1.Azure Data Lake Storage (ADLS) Gen2のストレージアカウントの作成 3-2.ストレージアカウントのデータストレージコンテナの作成 3-3.ストレージアカウントの利用ユーザー権限の設定 3-4.データ書き込み用のSASコードの実行 3-5.Azureアプリの設定 4.SAS Viya側の設定とAzure Synapseへの接続 4-1.SAS Studioでの設定 4-2.Azure SynapseのSQLデータベースをSASライブラリとして定義 4-3.Azure Synapseへデータの書き込み 2.Bulkload機能について なぜSAS ViyaがBulkload機能を使用してAzure Synapseに効率的にデータを書き込む際にADLS2サービスが必要なのか、そしてそのプロセスがどのように行われるのかを説明します。 Azure Synapse Analyticsは、柔軟性が高く、高いスループットのデータ転送を可能にするために、COPY

The significance of upholding trustworthy AI standards transcends multiple industries. Within retail, AI can potentially wield considerable influence in driving customer experiences, optimizing operations, and shaping business strategies. However, it is crucial to ensure that AI technologies are developed and deployed in an ethical manner, prioritizing human well-being and reflecting

If the last few years have taught us anything it’s this: business disruptions are not rare events. They are the norm. Today’s business leaders are grappling with logistics nightmares, economic upheaval, evolving consumer preferences, rapid technological advancements, regulatory changes, and armed conflicts. While it’s not possible to plan for every

This article shows how to use SAS to compute the probabilities for two correlated normal variables. Specifically, this article shows how to compute the probabilities for rectangular regions in the plane. A second article discusses the computation over infinite regions such as quadrants. If (X,Y) are random variables that are

The biggest challenges of our time won’t be solved in silos. To tackle complex problems, we’ll need ideas, perspectives, resilience and innovation rising from cross-sector collaboration and partnership. SAS recently hosted the 2023 Concordia United States Summit, a collaborative dialogue among public, private and nonprofit organizations designed to spur activities

Learn how to split your data into a training and validation data set to be used for modeling. In part 3 of this series, we replaced the missing values with imputed values. Our final step in preparing the data for modeling is to split the data into a training and

Los crímenes financieros, dentro de los que se ubica el lavado de dinero, provienen en su mayoría de fenómenos como el crimen organizado y el narcotráfico en México. Y una de sus manifestaciones más complejas es el envío de remesas, en las que se dificulta hacer un análisis de riesgo,