SAS Japan

活用事例からデータ分析のテクニックまで、SAS Japanが解き明かすアナリティクスの全て

データを使って新たな知見を見つけたいと思ったことはありませんか?実社会の問題を解決したいと思ったことはありませんか?そんなあなたにぴったりのイベントがあります! 昨年引き続きSASでは、SAS Hackathonというハッカソンイベントを開催します。過去のSASハッカソンについてはこちらをご参照ください。このイベントは開発者、学生、スタートアップ企業、SASの顧客・テクノロジーパートナーの皆様を対象としており、世界中から参加者を募集しています。 参加者は以下の分野の中から興味のある分野を選択し、テーマの設定、そのビジネス課題・社会問題の解決をチームで目指していただきます。チームは最低2人から最大10人までで、経験豊富なデータサイエンティストから初級者、パートナーやSASの専門家などなど幅広い方が、Microsoft AzureでSASとオープンソースを使用し世界規模でつながることができます。 また本イベントでは各チームにSAS Viyaを実行するクラウド環境や、メンタープログラムも用意されており、それぞれのチームにガイダンスやサポートが提供されます。SASコミュニティのHacker's Hubもご参考にどうぞ。 イベントスケジュール SASハッカソンのイベントスケジュールは以下のようになっています。 2021年12月1日〜2022年2月15日 登録期間 2022年1月26日 キックオフイベント 2022年1月5日~3月31日 デジタルラーニングポータルへのアクセスの有効化 2022年3月1日~3月31日 ハッカソン環境へのアクセス 2022年4月1日~4月7日 ビデオの録画とアップロード 2021年5月 ファイナリスト発表 2021年9月 受賞者イベント ガイドライン SAS Hackathonは、開発者、学生、スタートアップ企業、SASの顧客、およびテクノロジーパートナーを対象としています。チームは、組織内の人々、組織とテクノロジパートナー、またはグループへの参加を検討している個人で構成できます。 チームが取り組む実際の課題(ビジネスまたは人道上の問題)の説明が必要です。 テクノロジーパートナーは、顧客や学生とチームを組むことができます。 スタートアップ企業は、顧客や学生とチームを組むことができます。 参加者である皆様の抱える問題をハッカソンで取り組うことが可能です。テクノロジーパートナーと協力する顧客は、一緒に新しい市場につながるパートナーシップに向けて取り組むこともできます。 学生と開発者はチームを形成できません。ただし、顧客、パートナー、またはスタートアップチームに参加すれば、参加できます。 ※参加をしたいがチームが見つかっていない学生や開発者は、次の登録手順の4において「Looking for a Team」を選択してください 登録手順 SAS Profileを作成します(既に持っている場合は2へ) SASハッカソンのイベントページにアクセス 画面上部中央にある「Register Now」をクリック 以下の3つのタイプから合うものを選んでクリック Team Leader 参加するチームが決定しておりチームリーダーである人 Team

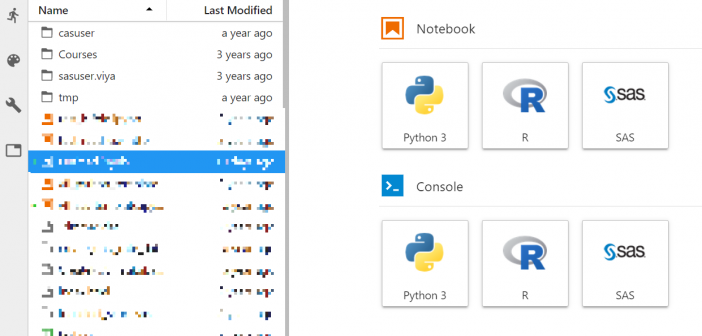

前回の投稿 【冬休みに勉強しよう】アナリティクスの学習(1) Skill Builder for Students では、学生向けのリソース・ハブである Skill Builder for Students に登録し、e-Learningでの学習についてご紹介しました。取り上げた学習コースでは、SAS Visual Analytics をツールとして用いていましたが、このソフトウェアは SAS Viya と呼ばれるアナリティクス・プラットフォームで提供されます。 SAS Viya は次のような特徴を持っています。 アナリティクスによる課題解決に必要な「データの管理と準備」「分析による発見とモデル構築」「分析結果の実装」を一つのプラットフォームで提供 機械学習、ディープラーニング、テキスト解析、画像解析、予測、最適化などAI機能を網羅 グラフィカルな操作、SAS言語、Python、Rなどによるプログラミング、REST APIによる機能提供を実装し、アナリティクスへのアクセスをオープンにする これらの特徴は、企業や組織でアナリティクスを用いて価値を発揮するために必要なものでありますが、学生がデータ分析を学ぶ場面では必ずしも重要なものではないかもしれません。しかし、GUIやSAS言語、オープンソース言語など、それぞれの学生が得意とするスキル、今後のキャリアに役立つ技術を磨くプラットフォームとしては有用です。SAS Viya は商用またはアカデミア向けのライセンス提供がありますが、教育目的には無償の SAS Viya for Learners がSaaS形式で提供されています。 SAS Viya for Learners は、SAS Skill Builder for Students と同様に、大学ドメインのメールアドレスを登録したSASプロファイルをお持ちであれば、無料で登録・利用することができます。クラウドでの提供ですので、ソフトウェアをインストールする必要はなく、Webブラウザからアクセスするだけで利用できます。GUI操作での可視化(SAS Visual Analytics)や、機械学習モデル作成ツール(SAS Model Studio)、SASプログラミングについては、SAS Skill Builder for

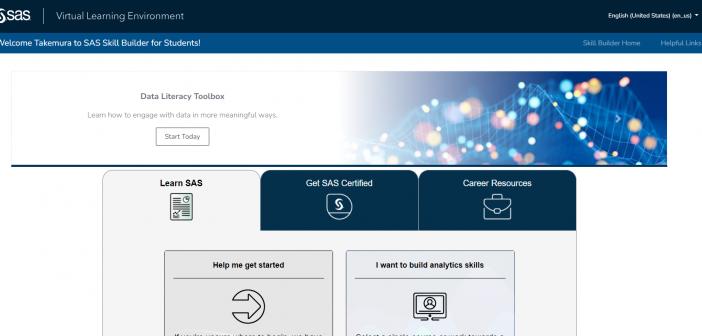

学生の皆さんは今日から冬休みでしょうか。「卒論でそれどころじゃないよ!」という方もいるかもしれませんが、この期間に「何か新しい勉強を始めてみようかな」と思われる方も多いのではないでしょうか。 データサイエンティストが「21世紀で最もセクシーな仕事」と言われてから10年近くが経とうとしています。しかし、社会におけるデータの活用はまだまだ発展途上であり、そのための人材は依然として高い需要があります。「データサイエンティスト」はそのなかでも、多くの高度な知識と技能を持った人材ですが、デジタル・トランスフォーメーション(DX)と呼ばれる業務改革が進む中、高度人材だけでなく、より広範囲の人たちがデータを活用した仕事に従事することが求められています。数理科学とテクノロジーを駆使するデータサイエンティストでなくても、アナリティクスに関わり、自分なりの知識とスキルを発揮することができます。 SAS Skill Builder for Students は、SASソフトウェアと統計解析・機械学習を中心に、「データリテラシー」や「ビジュアライゼーション」といったより基礎的なの知識やスキルを無料で学習できます。また、認定資格取得の案内や、アナリティクスを活用したキャリアについての情報も提供しており、アナリティクスの初学者からデータサイエンティストのキャリアを構築しようとする学生まで、多くの方に活用いただけます。この機会にぜひ登録してください。 登録方法は次の4ステップ SAS Skill Builder for Students にアクセス SASプロファイルをお持ちでない学生は「SAS プロファイルを新規に登録」から登録 ※ 登録するメールアドレスは大学ドメイン(.ac.jpなど)のものを入力してください。 登録したSASプロファイルのメールアドレスを SAS Skill Builder for Students のログイン画面で入力 My Trainingの画面でLicense Agreementを読み、同意のチェックボックスにチェックを入れて「Submit」 登録・ログインに成功するとこちらのようなホーム画面が表示されます。 「Learn SAS」「Get SAS Certified」「Career Resources」のタブがあり、それぞれe-Learningによる学習、認定資格の案内、キャリア構築のためのリソースが提供されています。 ここでは「ビジュアライゼーション」のe-Learningをご紹介します。SAS Visual AnalyticsというGUI操作による可視化ツールを利用して、データから示唆を得る方法を学習するトレーニングです。数学やプログラミングが苦手な方でも学習できます。 「Learn SAS」タブ→「Start Learning」→「Visual Analytics and Visual Statistics」→「SAS Visual Analytics 1 for SAS