SAS Japan

活用事例からデータ分析のテクニックまで、SAS Japanが解き明かすアナリティクスの全て

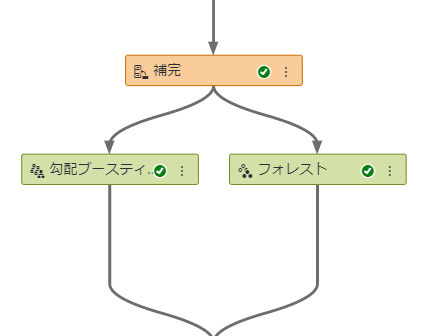

SAS Viyaでは、Model Studioを使用し、機械学習のモデル、時系列予測のモデル、テキストマイニングのモデルをGUIベースの簡単マウス操作で作成することができます。モデル生成プロセスをグラフィカルなフロー図として描き、実行するだけです。このフロー図のことを「パイプライン」と呼んでいます。 「SAS Viya: ビジュアルパイプラインで予測モデル生成(基本編)」では、モデル生成と精度評価の基本的な流れを紹介しましたが、今回は、生成したチャンピオンモデルに新しいデータを当てはめてインタラクティブにスコアリングを実行する手順を紹介します。また、スコアリング結果のデータの探索や、エクスポートまで試してみましょう。 「SAS Viya: ビジュアルパイプラインで予測モデル生成(基本編)」で作成したパイプラインでは、勾配ブースティングのモデルの方が精度が高い=チャンピオンモデルだと判断されました。 それでは、このモデルに新しいデータを当てはめてスコアリングを実行してみましょう。 まず、画面左側の機能ノードリストの「その他」セクション内にある「データのスコア」を「勾配ブースティング」ノード上にドラッグすると、「勾配ブースティング」ノードの下に「データのスコア」ノードが追加されます。 「データのスコア」ノードを選択し、画面右側で以下の項目を指定します。 ・モデルに当てはめるデータテーブル名 ・スコアリング結果データの出力先ライブラリとテーブル名 「データのスコア」を右クリックし、表示されるメニューから「実行」をクリックすると、スコアリングが実行されます。 スコアリング処理が完了すると「データのスコア」ノード上に緑色のチェックマークアイコンが表示されます。 それでは、スコアリング結果のデータを見てみましょう。 「データのスコア」ノードを右クリックし、表示されるメニューから「結果」を選択します。 すると、データのスコアの結果画面が表示され、「出力データ」タブ内で、データの中身を確認することができます。「予測:BAD=1」列に、顧客ごとの延滞確率に相当するスコア値が表示されています。 それでは、このデータを探索してみましょう。 「探索とビジュアル化」アイコンをクリックし、 表示される画面内で、このデータを探索用に保存する先のライブラリとテーブル名を指定し、「探索とビジュアル化」ボタンをクリックします。 すると、このデータに基づき、「SAS Visual Analytics – データ探索とビジュアル化」画面が表示され、データ探索やレポーティングが可能になります。 例えば、スコア値である「予測:BAD=1」変数と「資産に対する負債の割合」変数の関係性を探索したり、 スコア値が0.7以上の顧客データをエクスポートして、二次活用したり、等々も簡単です。 以上のように、SAS Viyaでは、データの準備はもとより、モデル生成からスコアリング、そして、スコアリング結果データの探索からエクスポートまでをGUIベースでシームレスに実施することができるんですね。 ※Enterprise Open Analytics Platform 「SAS Viya」 を知りたいなら「特設サイト」へGO! ※「ビジュアルパイプラインでスコアリング」は、SAS Viya特設サイトにデモ動画を近々公開予定です。

この記事はSAS Institute Japanが翻訳および編集したもので、もともとはJames Ochiai-Brownによって執筆されました。元記事はこちらです(英語)。 自己完結型のパッケージ内でソフトウェアを実行するというアイディアは、2013年のDockerの立ち上げと共に広まり始め、今ではアプリケーション開発とDevOpsのコミュニティにおけるホットなトピックとなっています。Red Hat社による最近の調査では、調査対象企業の57%が、いくつかのワークロードにコンテナを利用しており、次の2年間で採用数が2倍近くになると期待している、と回答しています。 SASはこのトレンドを認識しており、現在ではデプロイメント・オプションの一つとしてSAS for Containersを提供しています。これが仮想マシン上でSASを実行する手法の完全なリプレースになるとは思われませんが、そこには顕著なメリットがいくつか存在します。 1. アナリティクスへのセルフサービス型アクセス 組織の中には、「SASを利用したいが、それを手にできない分析担当者」を抱えているところもあります。また、SAS Platformを保有しているものの、そのオンボーディング・プロセスに承認手続きが設けられているビジネス部門も存在します。プラットフォームの運用管理者がファイルシステムやセキュリティモデルに変更を加えなければならない可能性があり、そのプロセスに時間がかかることもあります。 コンテナを利用すると、物事がよりセルフサービス型になります。IT部門はSAS用の標準的なコンテナイメージを準備し、それを社内のユーザー向けに提供します。分析担当者は用途に応じてその中から選択し、自分専用のインスタンスを起動するだけで、数分以内にSASでの作業を開始できます。Domino Data LabとBlueData は、こうした機能を提供するコンテナベースのデータサイエンス・プラットフォームの例です。 2. 様々なソフトウェア・ツールやバージョンに関するニーズへの対応が簡素化 SAS Platformの従来型の実装は、多数のユーザーによって共用されます。ユーザーは設定済みのソフトウェアを使用しなければなりませんが、それが最新バージョンであるとは限りません。コンテナを利用すると、IT部門はデータ分析担当者に対し、SASとオープンソースのソフトウェアを組み合わせた幅広い種類のコンテナイメージを提供することができます。例えば、SAS 9.4、SAS Studio、Jupyter Notebookを組み合わせたコンテナイメージも可能ですし、SAS Studio、Jupyter Notebook、R Studioのいずれからでもアクセスできる形でSAS Viyaの機械学習機能を提供するようなイメージも可能です。IT部門は、試用版ソフトウェアを提供することさえ可能です。開発者は、特定のプロジェクトに必要なソフトウェア・コンポーネントやAPI群を組み合わせて、独自のコンテナイメージを作成することもできるようになります。 3. ソフトウェア・アップデートの容易化 実際には、コンテナ内のSASソフトウェアがアップデートされることはありません。必要なのは、新しいバージョンで別のコンテナイメージを作成し、それを用いて別のコンテナを構築することだけです。つまり、ソフトウェアのアッグレード中にユーザーの作業を邪魔することは一切ありません。週末の作業も不要ですし、アップグレードがうまく進まないときに、どうやってシステムを元に戻せばよいかパニックになることもありません。新しいコンテナをテストし、準備が整った段階でそれをユーザー向けに展開すればよいのです。様々なバージョンのコンテナイメージを保持できるため、ユーザーは時間的な余裕をもって自分のコードを各バージョンでテストしたり、問題がないことを確認した上で新しいバージョンに移行したりできるようになります。 4. スケーラブルかつ柔軟で、隔離された計算処理環境 コンテナ・オーケストレーター(例:Kubernetes)は、多くのコンテナを起動することで、大きなコンピューティング・リソースを割り当てることができます。そのため、オンボードするユーザーが増えても、ジョブがスローダウンすることはありません。リソース消費が特に激しいプロセスを実行する場合でも、それが他のユーザーに影響することはありません。各コンテナは、それぞれのマシンのリソースの範囲内でのみ実行可能です。したがって、より多くのパワーが必要な場合は、コンテナを停止し、より大きなマシン上でそれを起動し直します。作業の完了後にコンテナを終了すると、そのマシンは他のユーザーのために解放されます。 5. アナリティクスをWebアプリに統合することが可能 今や、アナリティクスは分析担当者だけのものでありません。デジタル変革に取り組んでいる組織は、顧客がデジタルチャネルを通じて利用するWebアプリやモバイルアプリの背後にアナリティクスを組み込もうとしています。具体的には、画像処理、レコメンデーション、意思決定支援などを含むAIアプリケーションなどが考えられます。これらのWebアプリは従来の方式で実装されたSAS Platformと組み合わせて機能させることも可能ですが、その一方で、必要なSASソフトウェア、分析モデル、小型の実行エンジンとしてのサポーティング・コードだけで構成した実行エンジンを軽量なコンテナに実装すると複数の利点があります。こうすることで、開発者は、他のユーザーに影響を与えることなく、SASソフトウェアの設定やAPI群を変更する自由を手にします。これは、アプリケーションがPythonまたはJavaで実装される方法に似ています。 6. 自動モデル・チューニング モデルの中には、データが変化するたびに、あるいは新しいフィードバックを受け取るたびに、頻繁に更新する必要があるものもあります。コンテナを利用すると、そうしたモデルを再チューニングし、その結果をコンテナ内にパッケージし、実業務環境にデプロイするまでのプロセスを自動化することができます。 7. DevOpsやCI/CDによるデプロイメントの合理化/効率化 典型的なSASユーザーはDevOpsの世界には馴染みがないかもしれませんが、DevOpsは昨今の主流となりつつあるアプリケーション開発手法です。アナリティクスをWebアプリに統合したい場合、私たちはこのプロセスに沿って進める必要があり、それを最も簡単に行う方法が、コンテナを利用する手法です。SASコードとモデルをコンテナ内にカプセル化すると、アプリ開発者(=Dev)側では、デプロイのために運用チーム(=Ops)側に渡す前に、コンテナに接続しテストを実行できるようになります。「継続的インテグレーション(CI)」と呼ばれる手法では、アプリ(SASのパーツを含むアプリ)の全てのブランチ(分岐)における変更は、それらが一緒に正しく機能する状態を確保するために、定常的にマージされ、自動テストにかけられます。「継続的デリバリー(CD)」と呼ばれる手法は、本番の業務環境へのリリースまでのプロセスを自動化します。これにより、アナリティクス・プリケーションの開発とデプロイを数週間ではなく、数日または数時間で完了することが可能になります。 8. ほぼ全ての場所にデプロイすることが可能 コンテナはポータブル性に優れているため、オンプレミスのデータセンターから、パブリッククラウドや、ドローン/トラック/列車に搭載されたエッジデバイスに至るまで、あらゆる種類の場所でSASの実行エンジンを動かすことが可能です。 コンテナは、イマジネーション豊かなアナリティクス活用を実現可能にする大きなポテンシャルをもたらします。あなたがSAS Viyaのライセンスをお持ちの場合は、SASが運営するDockerイメージ・ライブラリへのアクセス権を有していますから、そこから事前準備済みのコンテナイメージの形でSAS

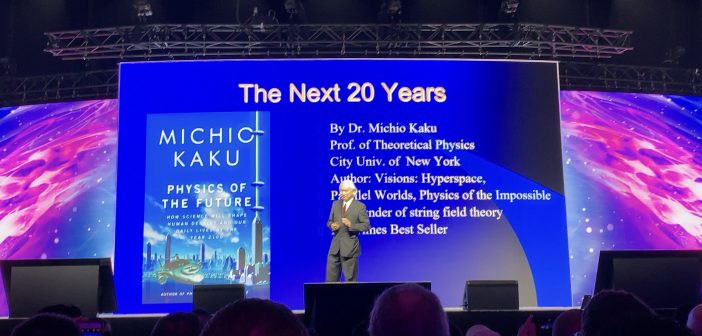

SAS Global Forum 2019もいよいよ最終日を迎えました。一日目、二日目、三日目に引き続き、最終日の参加レポートを掲載します。 データサイエンティストに必要な倫理 本日は”The Good, The Bad, and The Creepy: Why Data Scientists Need to Understand Ethics”というセッションに参加してきました。数十年前、データの活用はあくまで統計学の中のみのものであり、扱えるデータの数もごく少数でした。しかし、計算機の発展、理論の進歩、機械学習との交わりにより、近年では膨大かつ複雑なデータも処理することができるようになりました。それに伴い、データ分析の際のごく少数のミスもしくは悪意のある行為によって多くの人々に甚大な被害をもたらしてしまう可能性があると指摘しました。データサイエンスは非常に強力ですが、それを適切に活用するためにデータサイエンティストには倫理観が必要不可欠です。特に「引き起こしうる害」を認識し、「同意」に基づいてデータを使用し、「自分が何を分析しているか」を正確に把握することが必要と指摘し、特に三点目の重要性を強調しました。 分析に用いるアルゴリズムは適切かについて、常に気を配らなくてはありません。アルゴリズムが害を引き起こす例として、あるバイアスの持ち主が書いたプログラムにはそのバイアスが含まれている事例を紹介しました。例えば、Webでの検索結果にジェンダーギャップや人種間格差が見受けられるのは、関連するバイアスも持つ人物が書いたアルゴリズム内にそのバイアスが反映されているからかもしれません。他の例として、アルゴリズムに対する根本的な理解不足が問題を引き起こしうる事例を紹介しました。例えば、二つの要素が明らかに無関係と思われる場合でも、あるアルゴリズムが相関関係を見出したという理由でその二要素に関係があると結論付けてしまうのは、そのアルゴリズムについての理解が足りていないということです。数理統計をブラックボックスとみなしてはならず、背景理論について正確に把握し、何を分析しているかを意識し続けることが必要不可欠だと語りました。 また、これらに基づき、将来データサイエンティスト間にヒエラルキーが生じる可能性を指摘しました。基礎的な数学・統計学の知識があるだけでは不十分。倫理や関連法律を理解しそれをアルゴリズムに照らし合わせ、顧客や無関係な人々に害を与えてしまう可能性がないかを吟味し、必要に応じて手法を変えられるデータサイエンティストがヒエラルキーの頂上に来るはずだと主張し、倫理の重要性を強調しました。 SAS Global Forum 2019 に参加して 今回のSAS Global Forum 2019で最も印象に残ったことは「アナリティクスの可能性」です。本日の基調講演で、理論物理学者のミチオ・カク氏は「将来、すべての業界にAIが導入される。人類にとってロケットは大きな革命だったが、今後、データを燃料、アナリティクスをエンジンとして、さらに大きな革命が起ころうとしている。」と語りました。実際、様々なセッションへの参加を通して、アナリティクスが活躍する分野が非常に多岐にわたっていること、そしてそのインパクトが非常に大きいことを改めて実感し、将来私たちの生活がどのように変わっていくのかと想像して心を躍らせました。また、学生向けセッションへの参加を通じて、「アナリティクスを用いて世界を変えたい」という志を抱く同年代の学生が世界各地で切磋琢磨していることを知りました。近い将来、彼らと力を合わせて社会に大きなインパクトをもたらす”何か”をするため、今後も日々精進します。

SAS Global Forum2019 三日目の参加レポートです。一日目、二日目に引き続き本日も数多くの魅力的なセッションが行われました。参加したセッションの中から特に興味深いと感じたものをいくつかピックアップしてご紹介します。 難民支援のためのデータサイエンス 最初にご紹介するセッションは”Data4Good: Helping IOM Forecast Logistics for Refugees in Africa”です。IOM(国際移住機関)と協力しデータを用いた難民支援の事例について説明しました。 今回の分析は主にエチオピアの難民キャンプについて行われました。まず難民キャンプの規模や種類、さらにどのような物資が不足しているかについての情報を、バブルの大きさや色を用いて地図上に可視化します。この結果から安全な水や入浴・洗濯の機会など主に公衆衛生に関する課題をどのキャンプも共通して抱えていることが分かりました。そこで公衆衛生に関する水・石鹸・洗濯などの具体的な要素について、それが不足しているキャンプの数をグラフ化した結果をもとに援助の優先順位を策定し、より効果的な援助を実現しました。次に、キャンプで生活する難民についての分析です。キャンプごとに、老人が多い・女性が多いなどの特徴があり、それに応じて必要とされる支援は変わってきます。しかし流動的なキャンプにおいてその傾向は日々変化することから、支援の過不足が発生していました。適切なタイミングで適切な支援を行うため、年齢や性別などに基づき難民をいくつかのセグメントに分け、それぞれについて一つのキャンプ内にいる人数を予測するモデルを作成しました。このモデルの予測を用いることで支援物資を適切なタイミングで必要量を配分し、無駄を削減しながら必要な支援を届けることが出来ました。さらに、IOMから集めたフィードバックを用いて日々モデルを改善し、よりよい支援を追求しました。 優秀なデータサイエンティストになるには 次に”How to Be an Effective Statistician”というセッションについてご紹介します。データサイエンティストとして20年以上の経験を持ち、第一線で活躍し続けているプレゼンターが、自身の経験を踏まえながら優れた統計家になるためのヒントを伝えました。彼は”Effective Statistician” とは、「適切な分析を、適切な方法で、適切なタイミングに行える統計家」と定義しています。そして、そのためには2つのスキルが重要だと語ります。 一つ目は「リーダーシップ」です。データサイエンティストは主としてチームで分析に取り組みます。データサイエンスには統計のスキルだけでなく、分析分野についての専門知識や根本的なビジネススキルなど様々な能力が必要であり、それらを全て備えている人は多くありません。そこでリーダーの出番です。各メンバーの得意不得意を考慮しながらタスクを割り振り、各々の欠点を補いながら総合力でプロジェクトを進めていきます。しかしここで「独裁的なリーダー」になってはならないと強調しています。ある課題を解決するためのデータを用いたアプローチの仕方は一通りではありません。チーム内でディスカッションを続け、一人一人の意見を尊重することで、課題の本質を理解し、チームとして大きなヴィジョンを描けるのだと語りました。 二つ目は「データを適切に解釈する力」です。データは何らかの解釈が付与されて初めて意味を持ちます。また、それを適切に処理する上でもデータの深い理解は不可欠です。データの表面上の傾向に踊らされず、本質を見抜き適切なアプローチを取るためには、やはりビジネスの知識が役に立つと語っていました。また、データの不足が判明した場合にはそれを収集する仕組みを新たに構築するなど、臨機応変に対応する力も要求されるとのことでした。 セッションの後、データサイエンティストには幅広いスキルが要求されることに呆然としたという学生の発言がありました。それに対し彼は「自分の可能性を制限しているのは多くの場合ネガティブな自己認識。どんなに優秀なデータサイエンティストでも10年後を正確に予測することはほぼ不可能で、10年後の自分を決めるのは自分自身。理想の自分になるため、日々できることを継続することこそ一番の近道。」というメッセージを伝え、学生を勇気づけていました。とても印象に残った言葉でした。 Kick Back Party さて、三日目の夜にはKick Back Partyが開催されました。バンドの演奏やカウボーイ衣装での記念撮影など様々な余興が催され、各々が素敵な時間を過ごしていました。個人的には、本場テキサスでロデオマシーンを楽しめたことが印象に残りました。日本でのパーティーとは一味違うアメリカらしい陽気な雰囲気を味わうことができ、貴重な経験となりました。