SAS Japan

活用事例からデータ分析のテクニックまで、SAS Japanが解き明かすアナリティクスの全て

新型コロナウイルスの感染拡大により私たちの日常生活は大きく変化しており、自宅で過ごす時間も増えています。この機に「新しく統計学やプログラミングを勉強し始めたい!」、「SASの認定資格を取りたい」と考えている方も少なくはないのでしょうか。コロナウイルスの影響により在宅を余儀なくされた皆さんに、SASはさまざまなオンライン・コースを含むSAS®トレーニング・リソースを30日間無料で提供しています。(プレスリリース) 本記事では、提供されているオプションの中からSAS Learning Subscriptionの紹介をします。これはVirtual Learning Environment のなかで提供されているSASのe-learningが集まったポータルです。 1.SAS Learning Subscriptionに登録しましょう 最初にSAS Learning Subscriptionの登録手順です。こちらのページにアクセスして、以下の手順で登録してください。 SAS Learning Subscription 登録手順 from SAS Institute Japan 2.Learning Pathを選択しましょう SAS Learning Subscriptionにはオンラインで受講可能なLearning Pathが複数あり、またテーマごとにショートビデオや学習コースが設置されています。本コースの言語は英語で、コース内動画は英語字幕に対応しています。今回は、Learning Pathの中からSAS Programingを実際に学びながらSAS Learning Subscriptionの紹介をしていきます。 先ほどのSAS Learning Subscriptionへの登録を行うと、Virtual Learning Environmentへ移動します。画面左上をクリックして展開し、SAS Learning Subscriptionを選択してください。 ページ中央に上図のようなLearning Pathの一覧が載っています。ここで、自分の興味にあうLearning Pathを選択してください。学習コースにはそれぞれショートムービーやcourse notes、リンクなどが掲載されています。基礎からその利用まで順を追って説明がされるため、プログラミングなどに自信がない方でも取り組みやすい点が特徴です。 3.コースを受講して学習を進めましょう それではSAS Learning Subscriptionの学習コースの中からSAS Programing1: Essentialsを実際に進めてみましょう。以下のスライドで、最初のLessonであるCourse

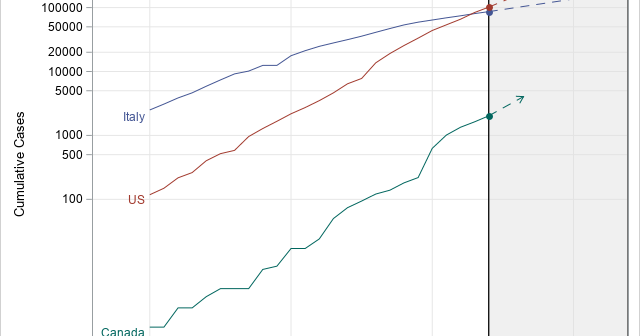

この記事はSAS Institute Japanが翻訳および編集したもので、もともとはRick Wicklinによって執筆されました。元記事はこちらです(英語)。 2020年における新型コロナウイルスの世界的流行のようなエピデミック状況下では、各国の感染確認者の累計数を示すグラフがメディアによって頻繁に示されます。多くの場合、これらのグラフは縦軸に対数スケール(対数目盛)を使います。このタイプのグラフにおける直線は、新たなケースが指数関数的ペースで急増していることを示します。直線の勾配はケースがどれほど急速に倍加するかの程度を示し、急勾配の直線ほど倍加時間が短いことを示します。ここでの「倍加時間」とは、「関連状況が何も変わらないと仮定した場合に、累計の感染確認者数が倍増するまでに要する時間の長さ」のことです。 本稿では、直近のデータを用いて倍加時間を推計する一つの方法を紹介します。この手法は、線形回帰を用いて曲線の勾配(m)を推計し、その後、倍加時間を log(2) / m として推計します。 本稿で使用しているデータは、2020年3月3日~3月27日の間の、4つの国(イタリア、米国、カナダ、韓国)における新型コロナウイルス感染症(以下、COVID-19)の感染確認者の累計数です。読者の皆さんは、本稿で使用しているデータとSASプログラムをダウンロードすることができます。 累計感染者数の対数スケール・ビジュアライゼーション このデータセットには4つの変数が含まれています。 変数Region: 国を示します。 変数Day: 2020年3月3日からの経過日数を示します。 変数Cumul: COVID-19の感染確認者の累計数を示します。 変数Log10Cumul: 感染確認累計数の「10を底とする対数」(=常用対数)を示します。SASでは、LOG10関数を用いて常用対数を計算することができます。 これらのデータをビジュアル化する目的には、PROC SGPLOTを使用できます。下図のグラフは感染確認者の総数をプロットしていますが、総数の縦軸に常用対数を指定するために「type=LOG」と「logbase=10」というオプションを使用しています。 title "Cumulative Counts (log scale)"; proc sgplot data=Virus; where Cumul > 0; series x=Day y=Cumul / group=Region curvelabel; xaxis grid; yaxis type=LOG logbase=10 grid values=(100 500 1000

この記事はSAS Institute Japanが翻訳および編集したもので、もともとはLucy Kosturkoによって執筆されました。元記事はこちらです(英語)。 あなたは今まで、実際に現地に行かなくても熱帯雨林を助けることは出来ないかと考えたことはありますか?考えたことがないでしょうか。 でも今がチャンスです。地球をまもるための活動もバーチャルで実施することがでる時代です。私たちの熱帯雨林プロジェクトでは、人工知能(AI)について少しずつ学びながら熱帯雨林を保護する機会を、家で過ごしている児童・生徒の皆さんに提供します(もちろん、大人の方にもご協力いただけます!)。こちらがご自宅でもできる学習ステップガイドです。 このガイドは4つのステップに分かれています: Step1: AIが人類のためにどのような役割を担うのか理解しよう Step2: 熱帯雨林のためにどのようにAIを活用するか見てみよう Step3: 画像の分類に力を貸してください Step4: さらにAIを用いて解決できる他の問題を見つけよう Step 1: AIが人類のためにどのような役割を担うのか理解しよう 私たちは、電気によって生み出された力やインターネットを通じて形成された世界全体の繋がりから、人類の歴史や人々の生活・労働上での技術の転換を知ることができます。AIはそれらの技術の最先端に過ぎません。いわゆるスマート家電から電気自動車まで、AIは私たちが考えていた働き方・運転の仕方・学習など多くのことを変化させてきました。 AIは人間と機械の長所をつなぎ合わせます。コンピュータの処理速度と高い継続性に人間の知性を組み合わせることで、それぞれだけでは実現できないものを作り上げることができます。AIを用いると、私たちは人間にとっては危険なこと(危険な環境の探索など)をコンピュータに実行させるようにトレーニングすることや、監視カメラの管理など人間が継続し続けることが難しい作業をコンピュータに任せることができます。これらは、ルールを設定することが容易な直感的な問題ではなく、未知で予測不可能な状況が溢れている問題です。プログラマーはコンピュータが必要とするルールを開発するのが困難なので、AIを使用して命令を開発します。 例として、複数選択と記述で答える質問がある学生の課題を採点するために開発されたコンピュータプログラムについて考えてみましょう。 複数選択式の質問には4つの選択肢がありますが、その中で正解は1つです。プログラマーは、その学生の回答が正解かどうかを評価する従来のコードを作成します。そのルールは簡単で、「Q:生徒の回答は正解と一致しますか」「A:はい、または、いいえ」です。 では、記述式の質問はどうでしょう?記述の正解は1つではありません。その記述が正しいかどうかを判断するルールも存在しないかもしれません。「記述は何文字以上必要か」「段落の数はいくつか」「必要な単語・用いてはならない単語はあるか」など、記述を適切に採点するためのルールを作成する方法はなく、そのルールは様々な判断と細かい評価が影響してきます。 この場合、プログラマーは従来のコードの代わりにAIを使用します。この問題を解決するために、プログラマーはまず評価の高い記述と低い記述のサンプルを集めます。そのサンプルは多い方が望ましいです。そのサンプルに機械学習アルゴリズムを用いて、コンピュータが優れた記述の基準を識別できるようにします。コンピュータにあらかじめ指示すべきルールはわかりませんが、そのルールが有効かどうかを判断することが出来ます。別のサンプルを用意して、先ほど作成したルールを適応したときに評価の高い記述と低い記述に分類されているかどうかを確認することで、ルールの基準をテストできます。 森林破壊など、世界規模の問題に取り組む際も同様の手法を適用することが出来るのです。 Step 2: 熱帯雨林のためにどのようにAIを活用するか見てみよう SASはIIASAと提携し、AIの専門知識と科学システム分析を統合して、地球を見るための新しい「目」を作りました。この提携によって、惑星映像から森林破壊の領域を自動的に検出できるようになります。コンピュータは何百万もの衛星画像を調べることにより、森林破壊の影響を受けた熱帯雨林の範囲を科学者に警告します。これにより、400万㎢を超える熱帯雨林を短期間で調査し、衛星画像が更新されるたびに調査を繰り返すことが出来ます。