Finanzdienstleister haben aktuell massive Herausforderungen beim Management ihrer Daten: Der Kostendruck zwingt einerseits zu einem hocheffizienten Betrieb („run“). Zugleich wandeln sich andererseits die Prozesse im Business, Stichwort Digitalisierung („change“). Die drückenden Regeln der Aufsicht scheinen sich nicht vereinen zu lassen mit dem Anspruch der Kunden, flexibel, fix und doch datensparsam bedient zu werden. Denn das hungrige „Machine-Learning“-Biest will gefüttert werden. Mit frischen Daten aufgepäppelt für die Vorstandsbühne.

Das „Datenpräparieren“ im Alltag ist knifflig

Dieses Jonglieren mit fragilen Kristallkugeln fordert Analysten wie Data Scientists täglich immens: Um am Freitag endlich das beste Modell „aus dem Hut zaubern“ zu können, quält man sich die vier Tage vorher bis spät in die Nacht des Donnerstages herum. Quellen erforschen, putzen und aufhübschen. Qualität nachmessen … nur um erschreckt festzustellen, dass „42“ hier eher nicht die Antwort sein kann! Also wieder von vorne.

Ein verspätetes Modell ist doppelt fatal … „KI = keine Implikation“?

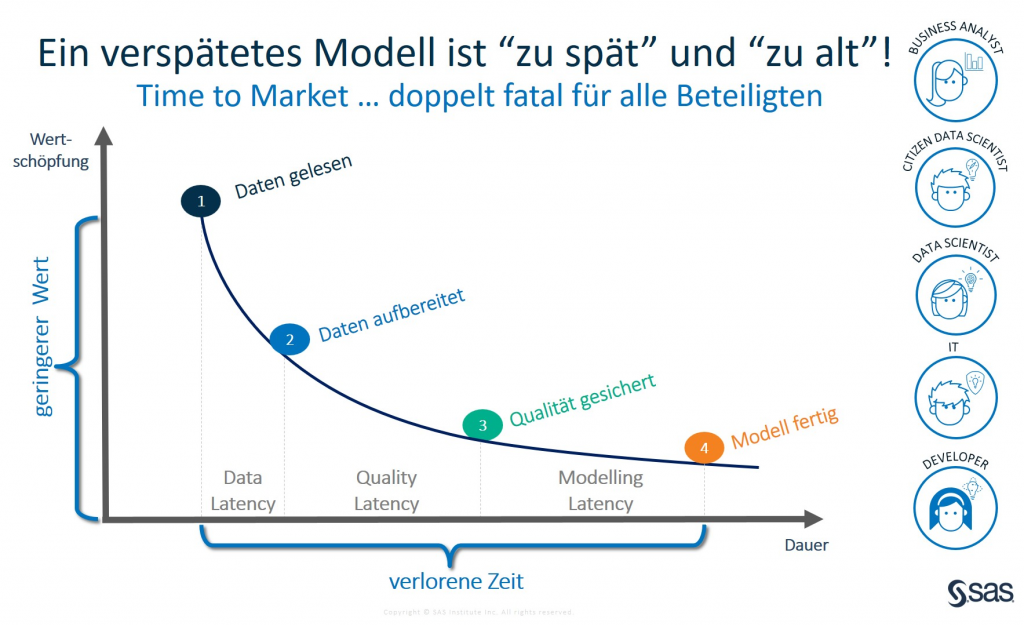

Erinnern wir uns: Das analytische Modell basiert auf einer Investitionsentscheidung. Jede Woche, in der es (noch) nicht produktiv im Einsatz ist, generiert es keinen Wert, keinen Cent.

Plus: Das analytische Modell basiert auf Daten. Daten ändern sich, da Menschen wie Märkte sich wandeln. Fatal zum Zweiten ist es also, wenn das Modell altersstarr an Ostern noch an den Weihnachtsmann glaubt.

Agil ist nicht anarchisch

Herkömmliche Datenstrategien sind nicht in der Lage, neue Businessmodelle zu unterstützen. Das „Wasserfallmodell“ ist ausgetrocknet: Weder hat der Fachbereich die Muße noch die IT die Ressourcen, x Pflichtenheft-Felder 2019 ins Warehouse zu flicken. Erfolgreiche FinTecs machen es vor, traditionelle Finanzdienstleister, selbst Großbanken folgen nun: „DevOps & DataOps“ ist keine Marsmission, sondern schlicht das, was die anderen schon am Fliegen haben …

Open-Source-Wühltische: Folks, it’s all about data!

Diese pragmatische Datenverarbeitung hat transparent zu erfolgen, nachvollziehbar und konform mit den Regeln. Der Prüfer in Frankfurt – und übrigens noch viel mehr der Kunde nebenan – darf zu Recht annehmen, dass es hier mit rechten Dingen zu geht.

Jener Prüfpunkt verschiebt sich rasant, wird immer früher erreicht: Ehemals hat die IT hoheitlich das DWH beschickt, hat man sich als Bank noch das „interne Modell“ amtlich abnehmen lassen; heute ist aber dessen Grundlage im hellen Licht der medialen Öffentlichkeit – Stichwort DSGVO, Datenklau und Sammelwut. Die saubere Verquickung von Daten reift zur Königsdisziplin. Das nachfolgende Zusammenklicken des Champion-Modells ist beinahe bereits „von der Stange“ zu haben oder liegt im „Open-Source-Wühltisch“ rum.

Ein praktisches Beispiel, umgesetzt in SAS Data Preparation

Wie kann man das in der Praxis angehen? Nun, wir haben bei SAS dazu ein Webinar aufgenommen. Schauen Sie sich an, wie Sie per Werkzeug im Browser ad hoc, die Qualität nicht nur messen, sondern auch gleich verbessern können in den spontan kombinierten Tabellen.

Und falls Sie (wie der Autor) ein paar Jahrzehnte schon in BASE SAS programmierend unterwegs sind: ja, prima! Auch diese Skripte laufen bestens… verteilt und In-Memory und mit Open Source drum rum!

Hier geht es direkt zum kostenlosen Webinar " Data Preparation für Banken – analytische Prozesse beschleunigen".