Aktuell sprechen wir mit vielen Banken über das Management ihrer Daten. Historisch schien die Bereitstellung von Information hinlänglich gelöst: Die IT-Abteilungen stellten diverse Mart-Daten & Analyse-Tools bereit. Punkt. Banken-Daten-Management: Mehr Schein als Sein?

In der Praxis allerdings haben sich Fachbereiche auch mit „eigenen Lösungen“ beholfen, die dann vorstandsseitig mehr oder minder „geduldet“ (oder ignoriert) den täglichen Bankbetrieb sicherten.

Beim Tüfteln der Datenstrategie für’s eigene Haus fragen wir uns: Geht’s durch die Dörfer Potemkins oder muss man gar den Kern sanieren? Lesen Sie hier, was nutzt und schon(end) geht.

Dieser trügerische Frieden im Bankenwesen jedenfalls steht aus drei Gründen „vor dem Aus“: Europäische Regulatorik, rigider Datenschutz und aufblühende Big-Data-Piloten erzwingen bei allen Bereichen im Traditionsinstitut nicht nur ein Überdenken, sondern ein Handeln innerhalb der kommenden Monate. So modernisieren erste Institute bereits taktisch ihre gewachsenen BI-Landschaften – wenig überraschend: Anfangen tun sie beim Datenmanagement. Nicht zuletzt, weil die Zeit drängt, entscheidet man sich dabei gerne für einen Lösungsanbieter, der rasch Ergebnisse nachweisen kann und „unakademisch“ den Fachbereich abholt, ohne dabei die IT-Erfordernisse zu umgehen.

Thema Regulatorik

„BCBS zwo-neununddreißig“ ist erwachsen geworden. Nach diversen Vorstudien und Beratungsprojekten „auf Papier“ (der zähen letzten 24 Monate) hat man als Institut jetzt die notwendige Sicherheit, was gefordert wird – und damit nun zu entwickeln ist. Erkenntnis: Der Fachbereich soll transparent die Prozesse verstehen und sein Data Dictionary pflegen, um jederzeit gegenüber Prüfern, Nachbarn und dem Mutterkonzern auskunftsfähig zu sein.

(Und dabei spielt es keine Rolle, „wie systemrelevant“ man sich als Tochter fühlt: Die Briefe der Aufsicht sind verschickt und die Implementierung läuft an: Failure is not an option!)

Gut zu wissen, dass man hier nicht bei Null anfangend Applikationen bauen muss. Es gibt hierzu Standardsoftware für Glossar, Messpunkt und Dashboard. Diese Suite muss drei Dinge unter einem Dach vereinen: Data Management („das Fließen der Daten“), Data Quality („das Messen“) und Data Governance („das Steuern“). SAS bietet dies heute schon und verzahnt jene Disziplinen im Institut, die bisher aneinander vorbei „nach ihrer/der einen Wahrheit forschten“, aber bisher am Abgleichen manch lokaler KPI zwischen Excel-Makro und IT-Rechenkern scheiterten.

Vorteil: Innerhalb von drei Monaten läuft oft ein erster Prototyp. Den aktiv mitzugestalten und dann live zu bewerten – von jedem Einzelnen im Risk-Office bis zum Vorstand – das ist der entscheidende Vorteil im Endspurt zur regulatorischen Compliance. Der deutschen bzw. europäischen Aufsicht nachzuweisen: „Ja! Unser Haus hat etwas entwickelt und. Ja! Der Data Owner benutzt das auch wirklich“. Das wird das erfolgversprechendste Signal nach Frankfurt sein.

Thema Datenschutz

Nun gut, manches Haus vertraut beim Melden „mal auf die Mutter“ und befüllt vorerst nur verordnete DQ-Schnittstellen – auch da man sich (als altes Opfer der „Basel II“-Gängeleien seinerzeit) wenig Vorteile für das eigene Geschäft erwartet. Irrtum.

Und ähnlich irrtümlich das nächste Thema „Datenschutz und Kunde“! Mag die Rechtslage auch klar sein, so können bisher nur wenige Institute Folgendes sicherstellen: Kunde Herrmann ruft an und will wissen, warum er dieses Werbemailing kriegt, obwohl er doch letztens laut und deutlich widersprochen hat?! (Und das ist nicht bloß unschön; das ist juristisch ein Rechtsverstoß). Aber so einen „opt-out“ über alle Kanäle in die letzte Stammdatenecke zu verteilen, das ist real knifflig – insbesondere dann, wenn moderne Kunden über Callcenter („Hallo, Herr Mahn?!“), ausgelagerte Web-Portale („fam.herrmann2@wäb.de“) oder Twitter & Co („@herrmann“) ins Tradititionsinstitut stolpern. Und irgendwie ja zu Recht erwarten, dass man sie (wiederer)kennt… Und respektvoll und nachhaltig pflegt. Oder eben nicht–

Dem zugrunde liegt der Mangel an jener analytischen Technik namens „Dublettensuche“. Um ähnlich Klingendes dem Kundenberater als „möglicherweise zusammenhängend“ auf den Bildschirm zu bringen, braucht es keinen teuren Data Scientist!

SAS hat dafür seit 15 Jahren ein Standardpaket im Angebot: Mit SAS Data Quality kann der ITler oder (mehr noch) der Marketingentscheider Kunden-von-überall-her zusammenführen und damit für Kampagnen jenen Überblick bekommen, den er braucht – als Wettbewerbsvorteil: mehr Merkmale, besseres Modell, höhere Response, üppiger Bonus. Gleiches gilt für den Risk-Controller mit seinen Kreditverbünden, Sicherheiten-Allokationen und RWAs. Und, nein, dazu muss man nicht mehr programmieren (lassen). Das lässt sich zusammenklicken, tunen und (siehe oben) gleich live dem Wirtschaftsprüfer vorzeigen. Denn unsere Regelwerke sind schon ab Werk hinlänglich „schlau“. Wie die Unternehmen, die darauf vertrauen – und die meisten hatten an diesem DQ-Problem in der Vergangenheit selber „rumgetüftelt“. Und jene, die heute noch am Markt sind, lösten es dann elegant per Toolkauf, bevor ihre besten Kunden unerkannt zur Konkurrenz abgewandert sind.

Thema Big-Data-Pilot

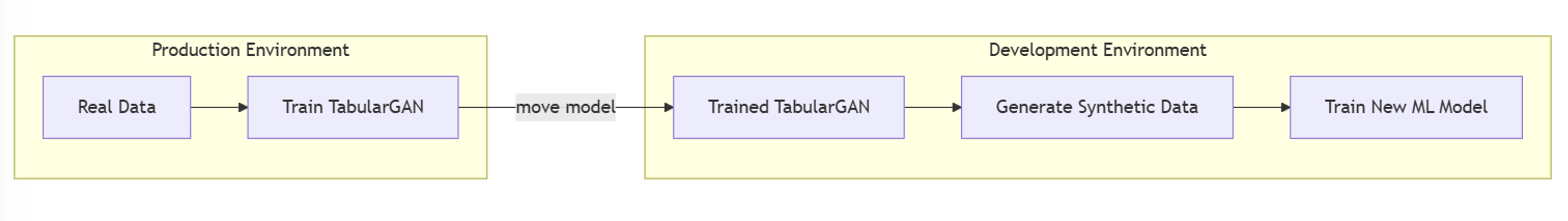

„Big Data?!“ Letztes Jahr noch konnte man sich mit einem „Haha, haben wir nicht!“ risikolos zurücklehnen. Heute wirkt das nicht nur auf Konferenzen “eher peinlich”. Heute ist die Frage eher „Wie bekommt das Haus die kreativen Laboranten wieder eingefangen?“. Fakt: Ein forsches “Alles geht!” im Nerd-Bällebad, das mag ja erfrischende Revolutionen lostreten, das ist für den Bankvorstand aber operationelles Risiko! Und betrifft damit übrigens das Kerngeschäft einer Bank, ihre IT, ihre Risikocontroller. Die jüngst noch fraglichen Usecases liefern mittlerweile hinter vorgehaltener Hand aus manch Hadoop-Piloten längst Ergebnisse, reizvolle Erkenntnisse über Betrug und Verhalten der Kunden im Netz. Dieses Wissen nutzbar, vertretbar und insbesondere betreibbar zu machen, das verlangt nach seriösen IT-Umgebungen.

- Jene müssen stabil sein

- Sie müssen nachvollziehbar sein – siehe oben: Regulatorik und Datensicherheit

- Sie müssen bezahlbar bleiben

Und all das fängt beim Management der Daten an. Banal, aber auch 2016 wird das nicht weniger wahr sein: Selbst im tiefsten Data Lake wird nur mit Wasser gekocht. Und das wird nicht durch noch so kräftiges Rumrühren wärmer!

SAS bietet eine Lösung, die stabil, nachvollziehbar und bezahlbar ist. Die vom ersten Tage an „jene Spezialisten im Labor“ in die Lage versetzt, ihre vielen Daten zu verstehen, zu prüfen und sauber standardisiert abzulegen. Mit flashy Klick-Oberflächen im Browser (SAS Data Loader) oder klassisch im ETL-Tool-Kontext (SAS Data Management Advanced). Die Analytik und die Datenqualitätsregeln sind schon eingebaut (SAS Code Accelerator): Das spart das ineffiziente Zusammen-Skripten von Joins, Lookups und all jenen lästigen Dingen, die den Data Scientist in seinem Forschen lähmen und den normalen Banker ratlos zurücklassen. Am Ende wird das Ergebnis, wenn es das Labor verlässt, von der IT ebenso „normal“ betrieben werden wie bewährte Data-Warehouse- und -Mining-Umgebungen, für die SAS seit Jahrzehnten unverzichtbar ist.