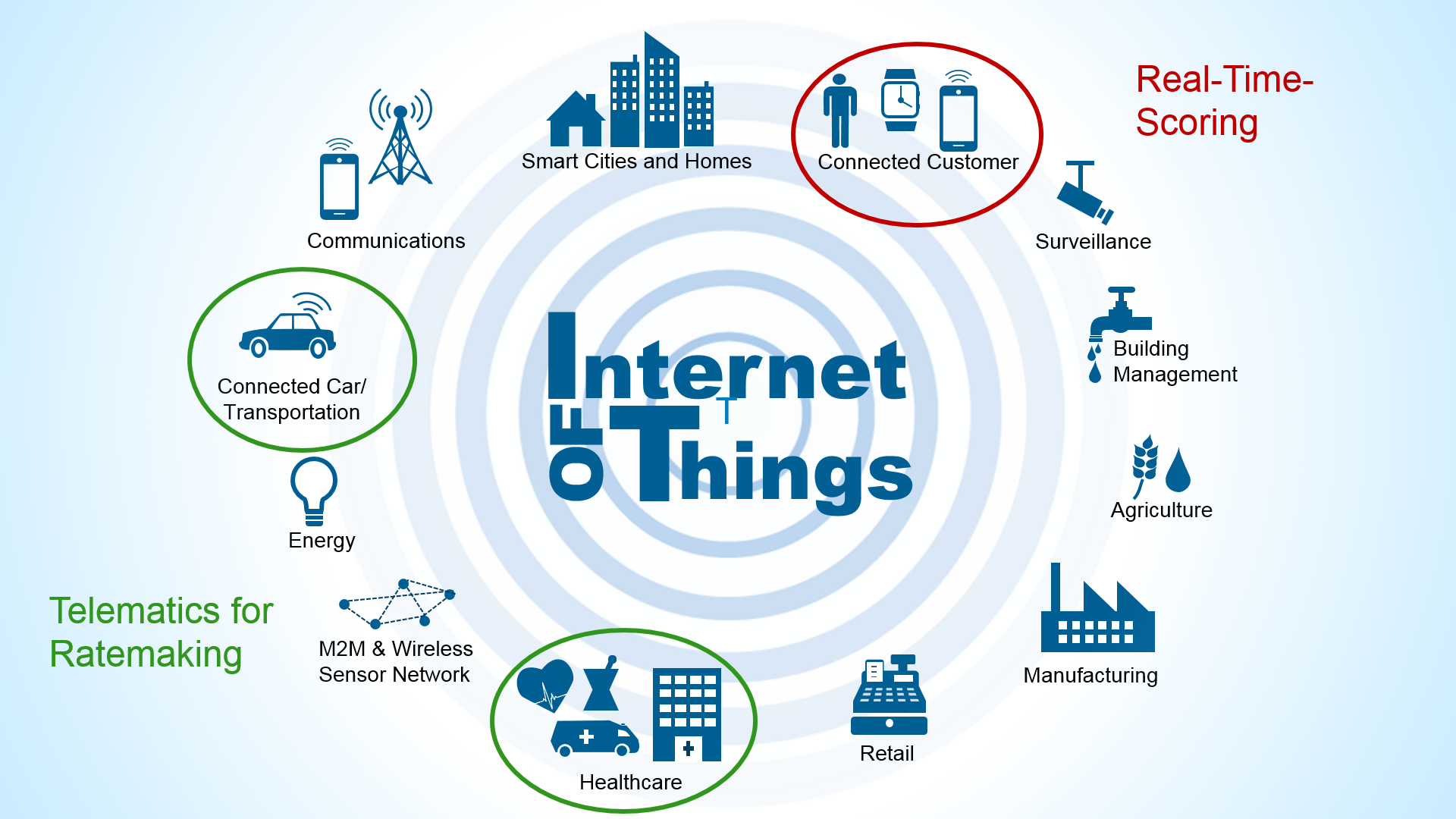

Die Zeit der Jahresrückblicke ist vorbei, endlich können wir unseren Blick wieder nach vorne richten. Seit einigen Wochen werden nämlich auf sämtlichen Portalen und Plattformen alle möglichen Prognosen für das Jahr 2017 ausgetauscht. So auch für Trends im Internet of Things (IoT). Ich lese da, ehrlich gesagt, meist nur mit einem halben Auge drüber und schnappe bestenfalls ein oder zwei neue Buzzwords auf. Heuer sind das für mich ganz klar die beiden Schlagworte Digital Twin und Edge Analytics.

Die Zeit der Jahresrückblicke ist vorbei, endlich können wir unseren Blick wieder nach vorne richten. Seit einigen Wochen werden nämlich auf sämtlichen Portalen und Plattformen alle möglichen Prognosen für das Jahr 2017 ausgetauscht. So auch für Trends im Internet of Things (IoT). Ich lese da, ehrlich gesagt, meist nur mit einem halben Auge drüber und schnappe bestenfalls ein oder zwei neue Buzzwords auf. Heuer sind das für mich ganz klar die beiden Schlagworte Digital Twin und Edge Analytics.

Digital Twins

Kann es denn Zufall sein, dass ausgerechnet in genau dem Jahr, in dem Ridley Scotts Blade Runner-Fortsetzung erscheint, unsere digitalen Zwillinge die reale Bühne betreten? Keine Ahnung. Für unsere persönlichen digitalen Kopien, die dann als Androiden unter uns wandern, sehe ich die Zeit jedenfalls noch lange nicht gekommen. Aber realistisch betrachtet könnten diese digitalen Doppelgänger zumindest für Unternehmen oder Organisationen keine reine Science Fiction mehr sein. Durch vergleichsweise kostengünstige Datenverarbeitung und die immer genauer werdende Sensorik sehe ich vor allem im Bereich der Simulation riesige Potentiale. Dem Gesetz der großen Zahlen folgend (umso größer das System und das Datenvolumen, umso genauer die Prognosen) ist der Digital Twin besonders für jene Unternehmen in Reichweite, die ihre Hausaufgaben in den Bereichen Skalierbarkeit, Datenqualität, Analytics und Decision Management schon gemacht haben.

Und so ein simulierter Zwilling, der hätte dann ja unbestritten Vorteile. Denn wer hätte nicht gerne einen 1A-Crash-Test-Dummy für vielfältigste Experimente zur Verfügung?

Edge Analytics

Edge Analytics ist, wenn man so will, das nächste Level von Streaming Analytics. Der Grundgedanke bleibt gleich, nämlich die Algorithmen zu den Daten zu bringen und nicht umgekehrt. Wie beim Berg und dem Propheten. Der Vorteil, den man sich davon verspricht: Minimierung der Time-to-Decision. Ein Produkt empfehlen? Eine Transaktion stoppen? Ein Setting ändern? Das alles soll unmittelbar, also minimaler Latenz, erfolgen.

Aber natürlich immer unter der Voraussetzung, dass die Entscheidung per se immer richtig getroffen wird. Und hier stehen wir genau vor der Herausforderung: Wie schaffen wir es, dass eine Device mit vergleichsweise geringer Rechenleistung und ohne Zugriff auf eine umfassende Datenhistorie gleich gute Entscheidungen treffen kann wie ein Analytik-Cluster auf Basis aller Unternehmensdaten?

Na ja, das wird wohl nie möglich sein. Aber vielleicht muss es das gar nicht. Denn wir müssen unterscheiden zwischen Entwicklung und Ausführung eines analytischen Modells.

Zur Entwicklung benötigen wir natürlich alle Ressourcen, die wir kriegen können. Algorithmen, Daten, Rechenleistung. Doch wenn ein gutes Modell einmal gefunden ist, entfällt dieser initiale Aufwand. Es kann dann theoretisch überall ausgeführt werden, zumindest bis es das „Haltbarkeitsdatum" überschritten hat und wieder aktualisiert werden muss.

Decisions-as-a-Service

Modelle müssen also administriert und automatisch verteilt werden. Das ist keine technische Hürde, aber eine organisatorische. Auch ohne IoT sind unternehmensweit 1.000 oder mehr analytische Modelle keine Seltenheit. Diese Zahl würde sich dann durch Edge Analytics noch vervielfachen! Ohne ausgereiftes Deployment-Konzept, sowie entsprechendes Model-Management (Repository, Training, Validation, Monitoring) ist an einen produktiven Einsatz also nicht zu denken. Dieser Aspekt darf bei allen Möglichkeiten, die sich in diesem Bereich auftun, nicht außer Acht gelassen werden.

„Decisions-as-a-Service" bekommt man also nicht geschenkt, denn es setzt einen gewissen Reifegrad im Bereich Analytik voraus. Wenn man diesen allerdings einmal erreicht hat, ist es eine relativ einfache Übung, eine passende Engine zum bloßen Ausführen der analytischen Modelle zu finden.

Im IoT-Umfeld sollte man allerdings unbedingt darauf achten, eine echte Event-basierte Engine auszuwählen und kein Micro-Batching. Eine übersichtliche Darstellung der Unterschiede finden Sie hier (http://sqlstream.com/).

Aber unter uns gesagt: Man kann sich das Ganze auch ersparen und gleich auf die SAS IoT Plattform setzen. Dann ist man für alles gerüstet und kann schon morgen loslegen.

Mehr dazu bei folgenden Events: