Big Data ist in aller Munde und beflügelt vom aktuellen Hype werden damit hohe Erwartungen verknüpft. Das bloße Sammeln bzw. Speichern großer Datenmengen ist jedoch nicht zielführend. Obwohl viele Unternehmen heute über eine gewaltige Menge an Daten verfügen, steht deren effektive Nutzung oftmals erst am Anfang. Die zentrale Herausforderung besteht darin, große Datenmengen aus vielfältigen Quellen mit einer hohen Verarbeitungsgeschwindigkeit zu analysieren, um daraus einen wirtschaftlichen Nutzen zu erzeugen.

Dass Big Data jetzt ein Thema wird, liegt maßgeblich in der fortschreitenden Weiterentwicklung von Prozessortechnologie und Speichermodulen begründet. Arbeitsspeicher war in der Vergangenheit eine limitierende und kostspielige Komponente von Rechnerarchitekturen. Im Arbeitsspeicher wurden neben dem Betriebssystem das aktuell auszuführende Programm, sowie die aktuell zu verarbeitenden Daten gehalten. Der überwiegende Teil der Datenspeicherung erfolgte auf Festplatten, einer Technologie der siebziger Jahre des vergangenen Jahrhunderts. Um eine angemessen schnelle Verarbeitung von größeren Datenmengen zu ermöglichen, wurden viele Technologien entwickelt. Beispiele sind intelligentes Caching, spezialisierte Datenstrukturen wie OLAP-Cubes und vor allem die traditionellen Datenbanken.

Der Begriff In-Memory beschreibt ein Konzept bei dem die Daten nicht, wie bisher, auf der Festplatte gespeichert und sukzessive verarbeitet werden, sondern im Hauptspeicher. Dies hat nicht nur den Vorteil, dass Zugriffe auf die Daten wesentlich schneller sind, es bereitet auch die Basis für die grundsätzliche Vereinfachung von Systemen und Programmen. Die Technologien und Optimierungen, die bisher erforderlich waren, um angemessen schnell mit einem System arbeiten zu können, werden durch den Einsatz von In-Memory überflüssig.

Das sich aus fortschreitenden Weiterentwicklung von Prozessortechnologie und Speichermodulen ergebende Potential für Innovationen wurde unter anderem von der SAP AG erkannt. SAP HANA ist eine Datenbanktechnologie, die im Jahr 2010 vorgestellt wurde. Bei HANA werden mehrere Technologien kombiniert. Die Verarbeitung der Daten kann sowohl zeilenorientiert, entsprechend der traditionellen Datenbanktechnologie, als auch spaltenorientiert, wie bei In-Memory-Datenbanken üblich, erfolgen. Gleichzeitig wird versucht, möglichst viele Daten in den Hauptspeicher zu verlagern um dadurch die Anzahl der Zugriffe auf Festplatten zu reduzieren und die sich daraus ergebenden Geschwindigkeitsvorteile zu nutzen.

Auch SAS greift die technologischen Innovationen auf. SAS bietet In-Memory Lösungen für anspruchsvolle Analytics. Bei den häufigsten statistischen Berechnungen unterliegen SQL-basierte Datenbanklösungen einigen Einschränkungen, wie etwa Spaltenbegrenzungen, verfügbarem Hauptspeicher und begrenzter Unterstützung von Dateiformaten. Zudem erfordert die iterative Natur von Datenanalysen und Data Mining-Operationen – wie etwa Variablenselektion, Größenreduzierung, Visualisierung, komplexer Datentransformationen und Modell-Training – viele wiederholte Datenoperationen. Für diese Prozesse sind SQL- und relationale Technologien nur bedingt geeignet. Diese Nachteile relationaler Technologie umgeht SAS mit einer In-Memory-Engine, die Datenanalysen, prognostische Modelle, Vorhersagen und Optimierungen beschleunigt.

SAS In-Memory Analytics ermöglicht Berechnungen im Hauptspeicher von mehreren, parallel arbeitenden Servern. Durch eine Optimierung der Algorithmen auf Standard-Servern mit hoher Rechenleistung und großem Hauptspeicher wird bei den Produktfamilien SAS High Performance Analytics und SAS Visual Analytics eine maximale Performance erreicht. Die Funktionalität geht dabei weit über die Programmiersprache „R“ hinaus. Der SAS® LASR™ Analytic Server adressiert als weltweit erstes System unterschiedlichste anspruchsvolle Analyse-Szenarien größter Datenmengen im Hauptspeicher. Er ist eine neue Art von In-Memory-Technologie für die nächste Generation hochleistungsfähiger Analytics.

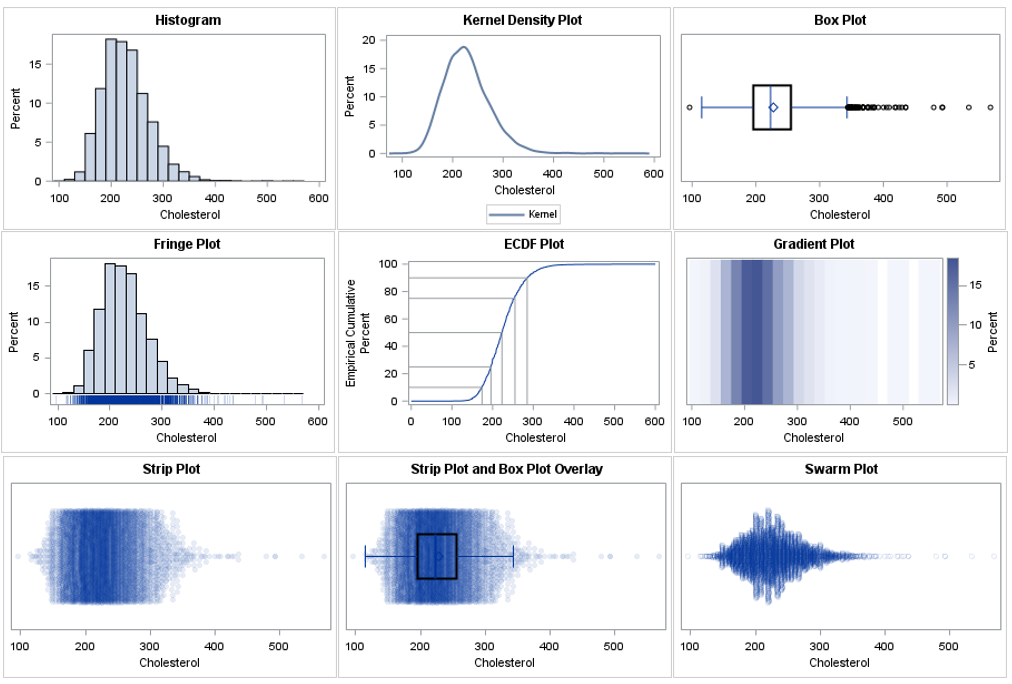

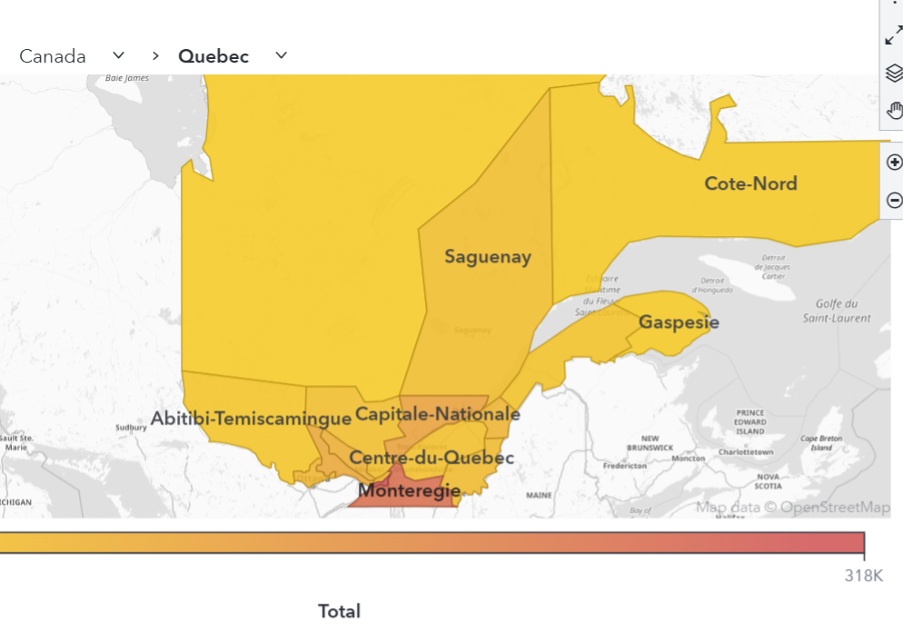

SAS Visual Analytics hat eine einfache, webbasierte Nutzeroberflächen, damit die Anwender interaktiv mit den Daten arbeiten können und ganz intuitiv zu wichtigen Informationen und Erkenntnissen kommen. Es müssen keine Stichproben oder Daten-Teilmengen gebildet werden. Der gesamte Datenbestand wird extrem schnell „In-Memory“ verarbeitet. Dadurch lassen sich Fragen beantworten, die bisher wegen beschränkter Rechnerkapazitäten nicht zu meistern waren. Anwender können Daten erforschen und analysieren und eine Vielzahl von Big Data-Herausforderungen stemmen. Typische Anwendungen sind etwa Risikomanagement, Kundenmanagement sowie Waren- und Sortimentsplanung.

Der nachfolgende Link verweist auf ein sehr sehenswertes Video mit Herrn Prof. Hasso Plattner zum Thema „In-Memory Data Management" . Weiterhin sei allen Interessierten der aktuelle Kurs am Open HPI empfohlen, der in dieser Woche startet: kostenlos, interaktiv, kompakt zu In-Memory Data Management in einer sechs Wochen Schulung. Hier geht's zur Anmeldung: https://openhpi.de/course/imdb2013