In meinem vorherigen Beitrag ging es darum, wie sich das Internet of Things (IoT) über den aktuellen Hype hinaus geschäftsfähig machen, also operationalisieren, lässt. Und um die Hürden, die Unternehmen in Sachen Analytics dafür überwinden müssen. Immer wieder spreche ich in diesem Zusammenhang mit Kunden über ein Thema, das nicht nur die Fachwelt bewegt: Machine Learning.

Ob prädiktive Wartung in der Fertigungsindustrie, automatisierte Beratung in der Finanzwelt oder das Einkaufserlebnis im Supermarkt der Zukunft: Maschinelles Lernen gilt als Schlüssel für moderne analytische Anwendungen. Unter Datenwissenschaftlern tobt der Wettbewerb um die modernsten Lernverfahren, die das Beste aus den Daten holen sollen. Geht es wirklich um „den geilsten Algorithmus“? Führt „algorithm porn“ zum Ziel?

Sprung vom Data-Science-Labor in die Produktion

Machine Learning ist kein Wundermittel. Oft herrscht die Vorstellung: Ich muss meine Daten nur an eine Maschine geben und „dann kommt schon irgendwas hinten raus“. So einfach funktioniert es nicht. Im Wesentlichen steckt klassische Analytics-Technologie dahinter, die Muster lernt und diese anwenden kann. Solche analytischen Modelle werden anhand von Beispieldaten trainiert. Dies geschieht überwacht, indem ich zu Beispielen den gewünschten Output präsentiere (etwa die Risikoklasse eines anhand von Stamm-, Demografie- und Transaktionsdaten beschriebenen Bankkunden oder die Fehlerkategorie, die hinter einem Wartungsbericht steckt). Nicht überwachte Lernverfahren finden Muster in Daten und lernen etwa, Gruppierungen zu beschreiben.

Anders ausgedrückt: Ein System lernt aus Beispielen und kann diese nach Abschluss der Lernphase verallgemeinern. Das heißt, es werden nicht einfach die Beispiele auswendig gelernt, sondern Muster und Gesetzmäßigkeiten in den Lerndaten „erkannt“. So kann das System auch unbekannte Daten beurteilen, es erfolgt also ein Lerntransfer.

Machine Learning hilft somit, gute Modelle zu entwickeln, aber diese müssen zum produktiven Einsatz kommen. Selbstlernend heißt selbstverständlich nicht, dass es für den Menschen nichts mehr zu tun gibt. Im Gegenteil, das Training von Modellen mit maschinellem Lernen ist gewissermaßen klassische Analytics: Der Data Scientist muss immer noch Daten richtig aufbereiten, algorithmische Parameter optimieren, verschiedene Verfahren miteinander vergleichen, gegebenenfalls kombinieren und am Schluss ein gutes Verfahren präsentieren, das valide Vorhersagen ermöglicht.

Predictive Maintenance: Rechtzeitig Ausfälle verhindern

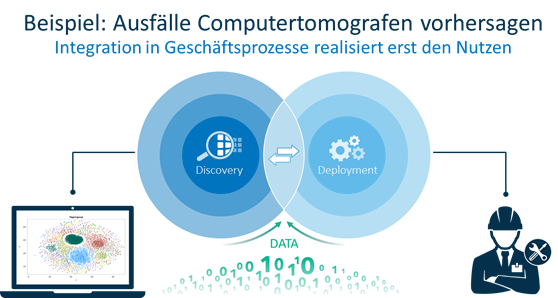

Ein praktisches Beispiel: Stellen wir uns einen Computertomografen vor, dessen Wartung optimiert werden soll, um Ausfälle zu vermeiden. Was benötigt man, um einen solchen analytischen Anwendungsfall erfolgreich in der Praxis zu realisieren?

In der Entwicklung braucht man erst mal gute Modelle, die aufgrund von Sensordaten und Eventcodes die Ausfallwahrscheinlichkeit einer Komponente (sei es die Röntgeneinheit, die Kühlung oder der Patiententisch) mit hoher Trefferquote und geringer Anzahl von Fehlalarmen vorhersagt – hier hilft Machine Learning. Im zweiten Schritt muss ich die Modelle in die Produktion bringen. Dazu benötige ich Geschäftsregeln, die analytische Vorhersagen mit Handlungsempfehlungen zusammenbringen und mir bei Entscheidungen helfen. Was mache ich, wenn die Ausfallwahrscheinlichkeit für den Patiententisch hoch ist? Wie schnell muss ich reagieren, wenn der Kunde einen Premium-Servicevertrag hat? Inwiefern unterscheidet sich die Vorgehensweise, wenn sich das Gerät in einem Krankenhaus oder in der Radiologie-Praxis befindet?

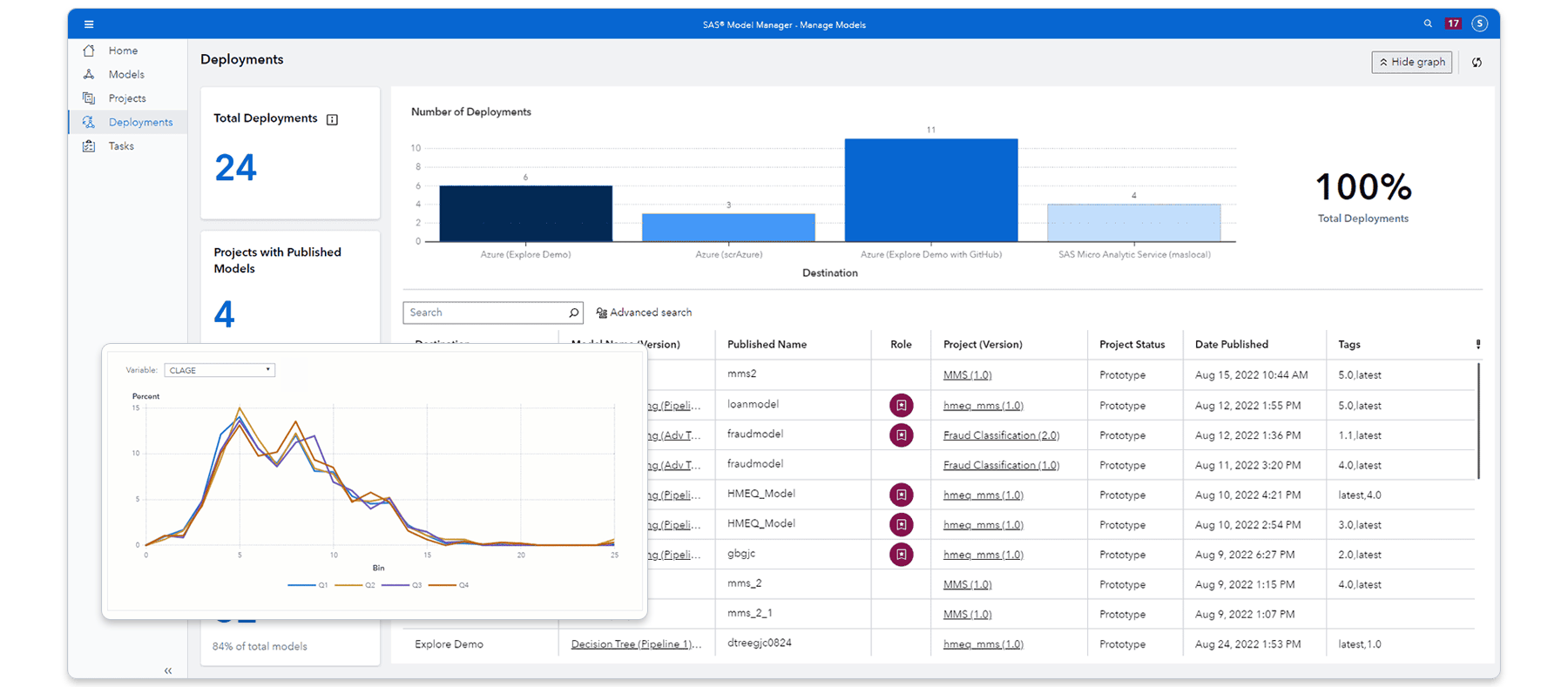

Ein weiterer wichtiger Faktor: Ich muss Modelle und Regeln dorthin bringen, wo die Daten entstehen beziehungsweise hingeleitet werden. Zum Beispiel in ein Hadoop-Cluster oder direkt in einen Datenstrom oder über eine Datenbank in ein operatives Dispatching-System, das dem Gerätetechniker sagt, welche Ersatzteile und Werkzeuge er in sein Fahrzeug packen muss, welche Kliniken er in welcher Reihenfolge anfährt und welche Komponenten er warten muss – unabhängig davon, ob das System schon ausgefallen ist oder nicht. Die Anwendung der Modelle und Regeln muss dann kontinuierlich überwacht werden. Hier ist eine Model Governance erforderlich, die die Effizienz bei der Registrierung von Modellen und die Auditierbarkeit sicherstellt. Zudem ermöglicht sie die automatische Prüfung der statistischen Modelle auf ihre Vorhersagekraft, wobei ein Alarm ausgelöst wird – diesmal, falls ein analytisches Modell ausgetauscht werden muss. Und dies managt dann wieder der Data Scientist, nicht der Gerätetechniker 😉

Und was hat das alles mit SAS zu tun?

SAS beschäftigt sich seit über 40 Jahren mit statistischen Analysen und hat nicht nur viele Algorithmen für Machine Learning im Portfolio, sondern ist auch einer der ersten kommerziellen Softwarehersteller, der bereits in den 1990er-Jahren neuronale Netze in sein analytisches Portfolio aufgenommen hat. Das ist also nichts Neues. Neu ist die größere Rechenpower, die heute zur Verfügung steht und es ermöglicht, dass solche rechenintensiven Verfahren auf große Datenmengen angewendet werden können. Und natürlich die dafür erforderliche Menge an Daten, die das IoT hervorbringt.

Also – hippe Technologie hin oder her: An der professionellen Integration von Analytics in die Geschäftsprozesse führt kein Weg vorbei, wenn es darum geht, Effizienzvorteile zu heben, Kundenzufriedenheit und Service-Qualität zu steigern oder Produktivität zu verbessern. Gerade, weil laut einer IDC-Studie erst 15 Prozent aller Unternehmen, die Analytics einsetzen, ihre Erkenntnisse auch entsprechend effizient operationalisieren. Moderne Analytik benötigt vor allem eine gute Plattform, auf der ich mit vielen Daten hantieren, ausprobieren und Verfahren vergleichen kann. Darum geht es, nicht um den coolsten Algorithmus. Und wie die Harvard Business Review gezeigt hat, konnten die Anwender, die es rechtzeitig geschafft haben, ihre Geschäftsprozesse entsprechend anzupassen und zu automatisieren, schon deutliche Kostenreduktionen realisieren.

Spannend? Weitere Informationen zum Thema Machine Learning und SAS finden Sie hier. Gerne diskutiere ich mit Ihnen ausführlicher, wie Sie Machine Learning im Zusammenhang mit künstlicher Intelligenz und Cognitive Computing für Ihre Geschäftsprozesse nutzen können.