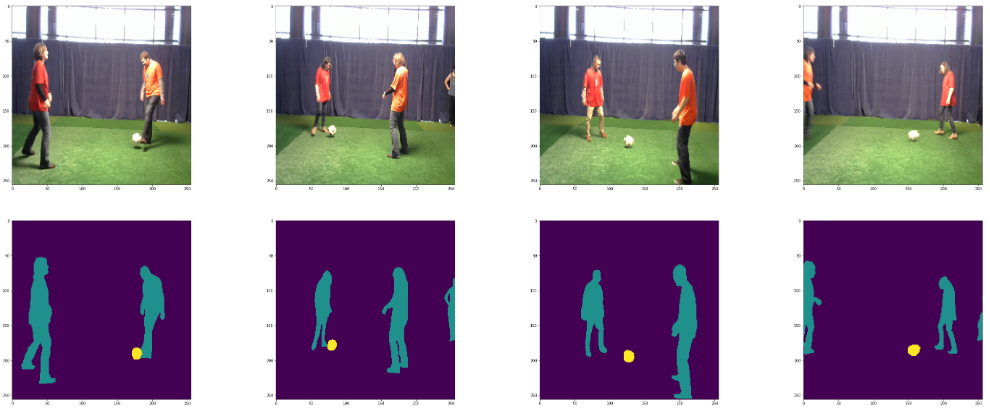

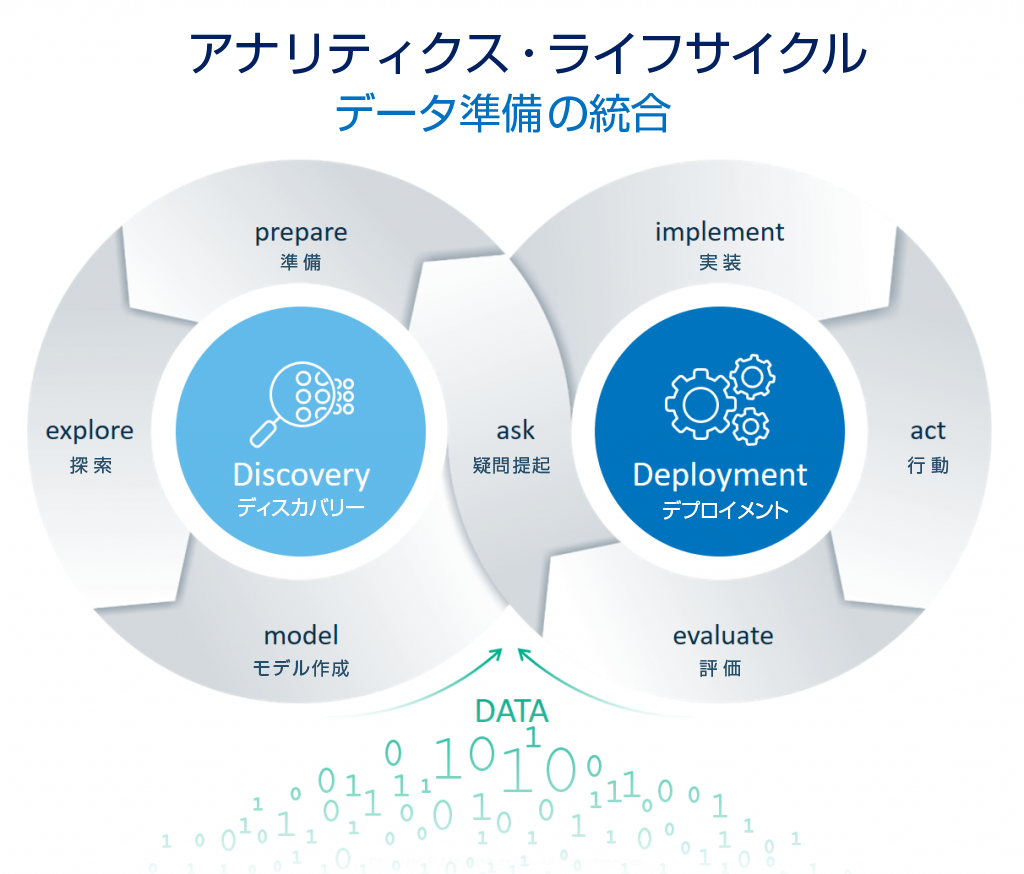

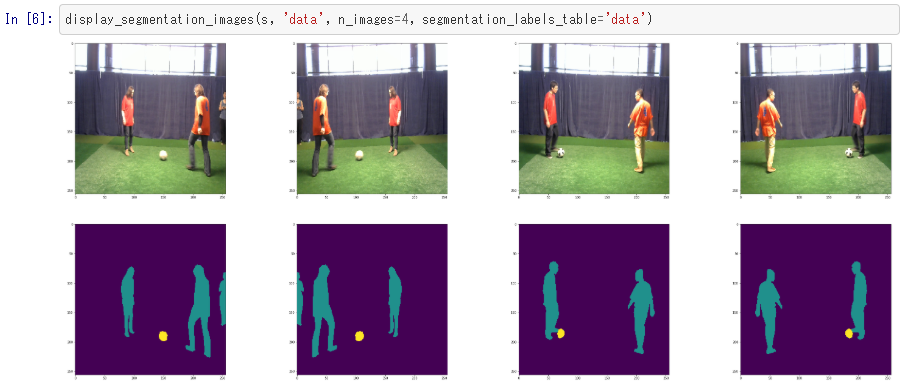

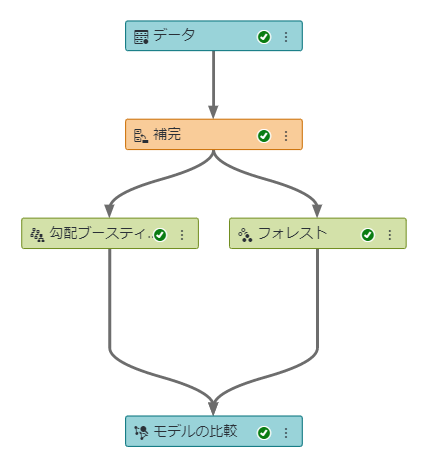

SAS Japanでは昨年末より”Data for Good”を目指す学生コミュニティ「SAS Japan Student Data for Good Community」を運営しています。このコミュニティは、Data for Goodを題材にデータサイエンスの一連の流れを体験する場として設立されました。今回紹介する勉強会も、その活動の一環です。詳しくは「Data for Goodを通じて"本物の"データサイエンティストになろう!」の記事をご覧ください。 四回目の勉強会ではFood Bankをテーマに、データを活用した課題解決の手法を学びました。 Food Bank Food Bankとは、品質に問題がないにもかかわらず市場で流通出来なくなった食品を、福祉施設などに提供する活動のことです。この取り組みは食に困っている人の支援だけでなく、食品ロスの削減の一翼も担っています。しかしながら、Food Bankの高頻度の利用は自立を妨げることにも繋がりかねず、利用者への適切なサポートが多くのFood Bankで課題となっています。 イギリスのHuddersfieldを拠点とするFood BankのThe Welcome Centre(TWC)もその一つです。利用者のある一部は、日を追うごとにパントリーの訪問回数が増え、依存度を増していくことがTWC内で問題となっていました。とは言うものの、沢山の利用者がいるの中で「誰がFood Bankに依存しているのか」を調査するのは非常に労力のかかる作業です。そこでTWCはDatakind社と共同のプロジェクトを開始し、Analyticsを用いて効率的に依存性の高い人を発見し、優先的なサポートを施すことに挑戦しました。このプロジェクトでは、実際に Food Bankへの依存性を推定する機械学習モデルの構築 依存性の高い人にフラグを立て、優先して支援すべき利用者を可視化する ことに取り組んでいます。詳しい内容はDataKind社の事例紹介(英語)をご覧ください。 解くべき課題を設定する これらの事例を踏まえ、私たちのコミュニティが「日本のFood Bankの課題」に取り組む場合、解くべき課題は何か・解決するために誰のどのような意思決定が必要か・どのようなデータが必要か、ディスカッションを行いました。 議論を進めていく中で、さまざまな意見が飛び交いました。その中には、「寄付を受けた食料品を完璧に消費するために、新規パントリーを出店する際の食料品の需要予測が必要ではないか」や「限られたボランティアの中で食品配送ルートの改善が大きなインパクトをもたらすのではないか」といった意見が出ました。ディスカッションをすることで、自分では思いつかない新鮮な発想に触れることができたり、テーマに広がりを持たせられることを感じました。アナリティクスの結果を活用するアクションを考えるための「課題設定」を実際に体験できた勉強会になりました。 コミュニティメンバー募集中! SAS Japan Student Data for Good communityでは引き続き学生の参加者を募集しております。社会貢献を目指す活動を通してデータサイエンティストの役割である「課題の設定」から「データを用いた解決法の提示」までの一連の流れを経験できます。 興味をお持ちでしたら下記の事項をご記入の上JPNStudentD4G@sas.comまでご連絡ください。 大学名 / 高校名 名前 メールアドレス