Laut aktuellem Gartner Hype Cycle ist der Hype um Big Data verglüht und die Phase der Ernüchterung ist eingetreten. Da höre ich schon viele in den Unternehmen sagen: "Hab ich ja gleich gesagt", "Das war total überbewertet", "Wir haben bei uns im Unternehmen keine Big Data", "Wir dürfen aufgrund des Datenschutzes sowieso nichts mit den Daten machen". Oder mein Favoriten: "Wir von der IT würden ja gerne, aber der Fachbereich hat keine Anforderungen bzgl. BigData" und "Andere in unserer Branche machen auch noch nichts". Und man weiß auch direkt, woran es liegt: "Der Gesetzgeber muss erstmal seine Hausaufgaben machen und die Rahmenbedingungen setzen - da ist noch vieles ungeklärt".

Für mich, der ich mich seit mehr als 25 Jahren mit Daten und BI beschäftige, sind das alles Indikatoren, dass man entweder die Chance hinter Big Data noch nicht versteht oder einfach nicht den Mut und die Durchsetzungskraft aufbringt, etwas Neues zu wagen. Denn tatsächlich sehen wir weltweit sehr spannende Anwendungsfälle von Big Data, die nicht nur interessant zu erzählen sind, sondern die alle konkreten Nutzen stiften - sei es Kosten zu sparen, Prozesse effizienter zu machen oder Umsatzpotentiale über neue Business Modelle zu erschließen. Beispielsweise möchte ich dazu diese Seite mit Best Practice Beispielen erwähnen.

Was also hindert uns, die steigende Datenflut für neue Vorgehensmodelle zu nutzen, statt uns verdrossen hinter Schutzwällen aus Datenschutzgesetzen und anderen Hindernissen zu verstecken?

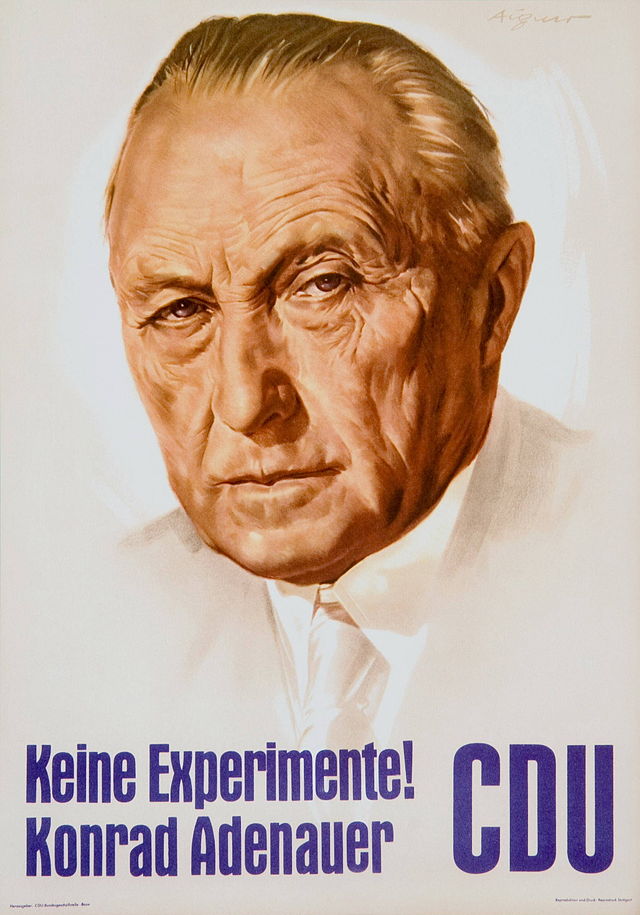

Quelle: Wikipedia

- Mentalität: Wir Deutschen sind neuen Dingen gegenüber prinzipiell erstmal sehr skeptisch. Insbesondere wenn es um neue Technologien geht. Ich habe oftmals den Eindruck, dass uns ein Wahlplakat aus den 60er Jahren noch heute tief im Kopf herumspukt: "Konrad Adenauer - keine Experimente". Dieses war ja, wie uns die Geschichte lehrt, eine sicherlich sinnvolle Strategie zum damaligen Zeitpunkt - zumindest für die politische Entwicklung von Deutschland. Dies ist jedoch in der heutigen schnelllebigen Zeit nicht mehr die richtige Strategie. Wir unterschätzen die Tragweite der digitalen Transformation und fühlen uns in vermeintlicher Sicherheit. Fälle wie Nokia sind für uns weit weg. Dabei finden diese Veränderungen, getrieben durch neue, sich schnell verändernde technologische Möglichkeiten jeden Tag statt. Seien es im B2C Bereich neue Nutzungsmöglichkeiten mobiler Endgeräten, die bestehende Prozesse wie bspw. Bezahlprozesse komplett verändern und möglicherweise große Auswirkungen auf ganze Branchen, das der Kreditkartenunternehmen, haben kann. Sei es die Nutzung von Sensordaten, um bspw. Wartungsprozesse oder Logistiksteuerungen komplett zu verändern. Wenn ich mir die BigData Anwendungsfälle anschaue, die wir bereits bei Kunden umgesetzt haben, gibt es auch keine Branche, die davon nicht betroffen ist. Und trotzdem: keine Experimente.

- "Sense of Urgency": Made in Germany hat sich noch immer durchgesetzt - kein Grund zur Panik. Keine Frage, wir Deutschen haben durch unsere Ingenieurskunst, durch solides Handwerken und durch strukturiertes strategisches Arbeiten einen weltweiten Ruf erarbeitet, der mit Qualität "made in Germany" unsere Volkswirtschaft zu einer der Führenden werden ließ. Qualität hat sich noch immer durchgesetzt. Selbst wenn andere billiger und schneller waren, haben wir immer am nachhaltigsten produziert. Aber: Die Produktwelt verändert sich. Einerseits steigt der Anteil von datenbasierten Produkten und Dienstleistungen im Anteil am Volkswirtschaftsvolumen. Andrerseits erwartet der Endverbraucher wie auch der Industriekunde entsprechend mit Datendiensten angereicherte Produkte und Dienstleistungen.

- Fokus IT-Effizienz: Nach meiner Erfahrung haben sich viele IT Abteilungen in den letzten Jahren aufgrund von Kostendruck und entsprechender Sparziele maximal schlank aufgestellt. Projekte müssen einen klaren ROI in kurzer Zeit nachweisen. Prozesse wurden ausgelagert, Mitarbeiterabgänge oftmals nicht mit jungen Leuten nachbesetzt. Zwischen IT und Fachbereich wurden entsprechend auf Effizienz getrimmte Prozesse implementiert. Die unbeabsichtigte Nachricht an die IT und Fachbereiche dabei war jedoch: Für neue Ideen ist kein Platz. Ausprobieren und sich mit neuen Dingen beschäftigen ist ineffizient. Im Zweifel bleibt dafür eh keine Zeit. Wir haben also das Experimentieren verlernt bzw. es möglicherweise unbewusst verboten. s. Adenauer: "keine Experimente".

Aber es verändert sich etwas. Da keiner etwas verpassen will, sehe ich zunehmend Aktivitäten in den Unternehmen, die ich folgendermaßen überschreiben möchte.

Die Suche nach dem goldenen Big Data Use Case

Ich habe in den letzten 15 Monaten mit vielen Unternehmen - IT wie Fachbereich - zum Thema Big Data gesprochen. Alle denken über Big Data nach, einige können den Begriff schon nicht mehr hören, so viele interne Workshops wurden bereits dazu durchgeführt. Die meisten sind auf der Suche nach dem Use Case - dem Anwendungsfall, den das Unternehmen quasi in eine neue Ära führen soll. Es werden Personen definiert, die sich mit Big Data beschäftigen, einige Unternehmen haben Innovationsteams gegründet, einige CIOs haben ihre Architekten auf Hadoop-Kurse geschickt. Die IT fragt endlich den Fachbereich, was man mit mehr Daten machen würde. Keine Frage - alles sehr sinnvolle Dinge. Nur irgendwie scheint der geniale Use Case nicht gefunden. Viele sagen mir, sie werden erst investieren, wenn der Fachbereich mit konkreten Anforderungen kommt, wenn sich ein Business Case ergibt. Die IT könne ohne nicht investieren (s. Punkt 3 oben). Meine These: Diesen Use Case werden sie nicht finden. Jedenfalls nicht in kurzer Zeit. Und ich bin mit der Meinung nicht allein, wie sich im Rahmen des Big Data Forums 2014 gezeigt hat.

"Clients who ask for 'use cases' are doomed. If you don't know why you need it, you cant expect others to know." @carstenbange #bigdataforum

— Joerg Blumtritt (@jbenno) November 4, 2014

Warum einfach, wenn es auch kompliziert geht?

Der Hype um Big Data hat dazu geführt, dass man hiermit etwas innovativ neues verbindet, eine Anwendung, die das bisherige Geschäft verändert. Dies ist aber irreführend, weil der Weg dorthin meines Erachtens nur über Bekanntes führen kann. Natürlich ergeben sich neue Chancen, wenn man bisher unbekannte Daten in seine Datenwelt integrieren und analysieren kann, noch besser, wenn diese Daten einem bei dem Auffinden neuer Erkenntnisse und bei dem Beantworten bisher unbekannter Fragen helfen würden. Aber dies ist kein einfacher Weg und die meisten Unternehmen sind hierfür nicht ausgerichtet - weder von den Skills noch von den Prozessen her. Einfacher ist es, sich mit bekannten, bisher aber weitgehend ungenutzten Daten und bekannten Fragen auseinanderzusetzen und hier Vorteile der neuen Technologien zu nutzen. Hierüber wird dann schrittweise Wissen und Erfahrung aufgebaut und zunehmend weitere Potentiale erkannt.

Für diesen ersten Schritt - bekannte Daten, bekannte Fragen - sehe ich drei naheligende Szenarien:

1. Das DWH entlasten

2. Unstrukturierte Daten nutzen

3. In einer Sandbox experimentieren

Das DWH entlasten

Nahezu jedes DWH ist bereits in die Jahre gekommen und beginnt, unter den zunehmendes Anforderungen zu ächzen. Seien es mehr Daten aufgrund von erhöhten Anforderungen zu Historienbildung, erhöhter Detailtiefe der Daten oder aus vorausgegangenen Mergern. Oder aber kürzer werdende Batchfenster kombiniert mit steigender Menge an Data Marts. Hier können neue Technologien wie Hadoop eine gute Entlastung bieten und gleichzeitig den Kostendruck der IT adressieren. Aufwändige ETL Prozesse können in günstiger Hadoop Hardware gerechnet werden und skalieren aufgrund der verteilten Architektur wesentlich besser. Da die Daten weiterhin in das DWH geschrieben werden, ist dies kein revolutionärer Schritt für die Architektur und den Endanwender. Auf diese Weise kann aber sehr schnell und effizient gelernt werden, wie Hadoop das heutige Warehouse sinnvoll ergänzen kann. Mit diesem Wissen können dann leichter weitere Use Cases umgesetzt werden.

Unstrukturierte Daten nutzen

Jedes Unternehmen hat hinreichend viele Texte, die heute weitestgehend ungenutzt gespeichert werden. Zudem stehen viele textuelle externe Informationen den Unternehmen zur Verfügung, die aber in ihrer schieren Menge nicht konsistent im Unternehmen genutzt werden. Diese Texte automatisch und mit aktueller Analysetechnik zu verarbeiten, kann ein einfacher und logisch nächster Schritt sein. Anreicherung von Kundendaten, Analyse von Beschwerden, Analyse von Werkstattberichten zur frühzeitigen Identifikation von Garantiefällen, Analyse von Nachrichtentexten zur Identifikation von wirtschaftlichen Schwierigkeiten von Unternehmen bspw. im Zuge von Rating Prozessen oder zur Identifikation von Geschäftspotentialen für einen B2B Vertrieb.

In einer Sandbox experimentieren

Bisher stellen wir den Anwendern wohldefinierte Datentöpfe zur Verfügung, die in der Regel nur einen kleinen Ausschnitt aus der Gesamtheit der Daten bieten. Oftmals werden sogar Strukturen zur Analyse vorgedacht (klassisches OLAP). Dass aus diesen Datentöpfen keine neuen Erkenntnisse gewonnen werden, erscheint nicht überraschend. Was wäre aber, wenn man den Fachexperten alle für Ihr Sachgebiet relevanten Daten zur Verfügung stellen könnte und sie in diesen Daten frei nach Zusammenhängen und Trends suchen könnten. Dann würden sie mit der Zeit auch andere Fragen als die bisher vorgedachten stellen und somit auf Basis ihrer Big Data weitere Ideen und Ansätze für Analysen erkennen. Das Ergebnis sind dann neue Hypothesen und Erkenntnisse über die zukünftigen Gestaltung des Geschäfts - Dinge, die mit der Abfrage von vorstrukturierten Vergangenheitsdaten nicht möglich sind. Diesen Ansatz bezeichne ich als "explorative Sandbox" - einer Umgebung zur freien Analyse auf Detaildaten, mit analytischen Werkzeugen und in einer abgeschlossenen Umgebung, parallel zur heutigen BI Landschaft. Über einen solchen Sandbox Ansatz können Sie im Unternehmen Neugier und neue Idee erzeugen, die dann Grundlage für weitere Big Data Ansätze sein werden. Nach einiger Zeit werden Sie dann in einem zweiten Schritt weitere, dann eher unbekannte Daten analysieren und mit den bisher bekannten Daten kombinieren. Mit analytischen Werkzeugen können Sie dann auch zunehmend Modelle abbilden, die Antworten auf bisher unbekannte Fragen liefern können. Alle drei Ansätze haben eins gemeinsam: die Bereitschaft und die Kultur zum Experimentieren. Also vergessen sie endgültig Adenauer. Sie brauchen Experimente! Schaffen Sie Raum dafür. Möglicherweise ist dies für uns Deutsche anstrengend. Dass es sich lohnt, zeigen die vielen positiven und interessanten Anwendungsfälle aus allen Branchen. All diese haben mit ersten Experimenten angefangen. Also: Suchen Sie keinen goldenen Big Data Use Case, bei dem Sie erstmal richtig investieren müssen. Fangen Sie in einem kleinen Bereich an und schaffen sie hiermit schnelle Erfolge.

Mehr Informationen finden Sie auch in dieser Slideshare: