Der heutige Gastbeitrag kommt von Mirjam Hartmann, Head of Marketing bei accentec. Überlassen wir ihr nun das Wort. Sie diskutiert darüber, dass die Flut an großen Datenmengen branchenunabhängig ist und allgegenwärtig und dass die datenproduzierenden Quellen kaum mehr überblickbar sind. Sie geht sogar noch weiter: Egal welchen Ursprungs diese Datenmengen sind, eines haben sie gemeinsam: Sie sind groß, komplex, schnelllebig und unstrukturiert bzw. rudimentär strukturiert. Diese Flut an heterogenen Daten gilt es sinnvoll zu verarbeiten und auszuwerten, um zusätzliche Kenntnisse daraus zu gewinnen. Doch was bedeutet dies technisch und wie sieht ein möglicher Ansatz mit SAS Viya und Apache Hadoop aus. Im klassischen Big-Data-Umfeld wird hierfür typischerweise ein Hadoop-Cluster auf einer beliebigen Cloud-Lösung aufgebaut, ein Data Lake konzipiert und die Daten anschließend mithilfe entsprechender Technologien, die für verteilte Systeme geeignet sind, verarbeitet.

Greenfield-Ansatz mit Apache Hadoop

Hadoop ist eine große (leere) Spielwiese und der Aufbau eines Hadoop-Clusters bedarf im Vorfeld einer wohlüberlegten und ausgereiften Konzeption. Es muss definiert werden, mit welcher Technologie bspw. die Dateningestion, Datenverarbeitung, Datenvisualisierung, Administration und noch vieles mehr stattfinden soll. Es steht eine große Auswahl an unterschiedlichen Tools zur Verfügung, die je nach Bedarf an das Hadoop-Cluster angebunden werden müssen. Wer einen Greenfield-Ansatz liebt und technisch (sehr) versiert ist, für den bietet dieser Weg eine schöne Möglichkeit von Null anzufangen und sich seine Modern Analytics Landschaft selbst aufzubauen. Alternativ ist es möglich, Hadoop als einen reinen Data Lake zu nutzen und die Daten mit SAS Viya weiterzuverarbeiten.

Brownfield-Ansatz mit SAS Viya

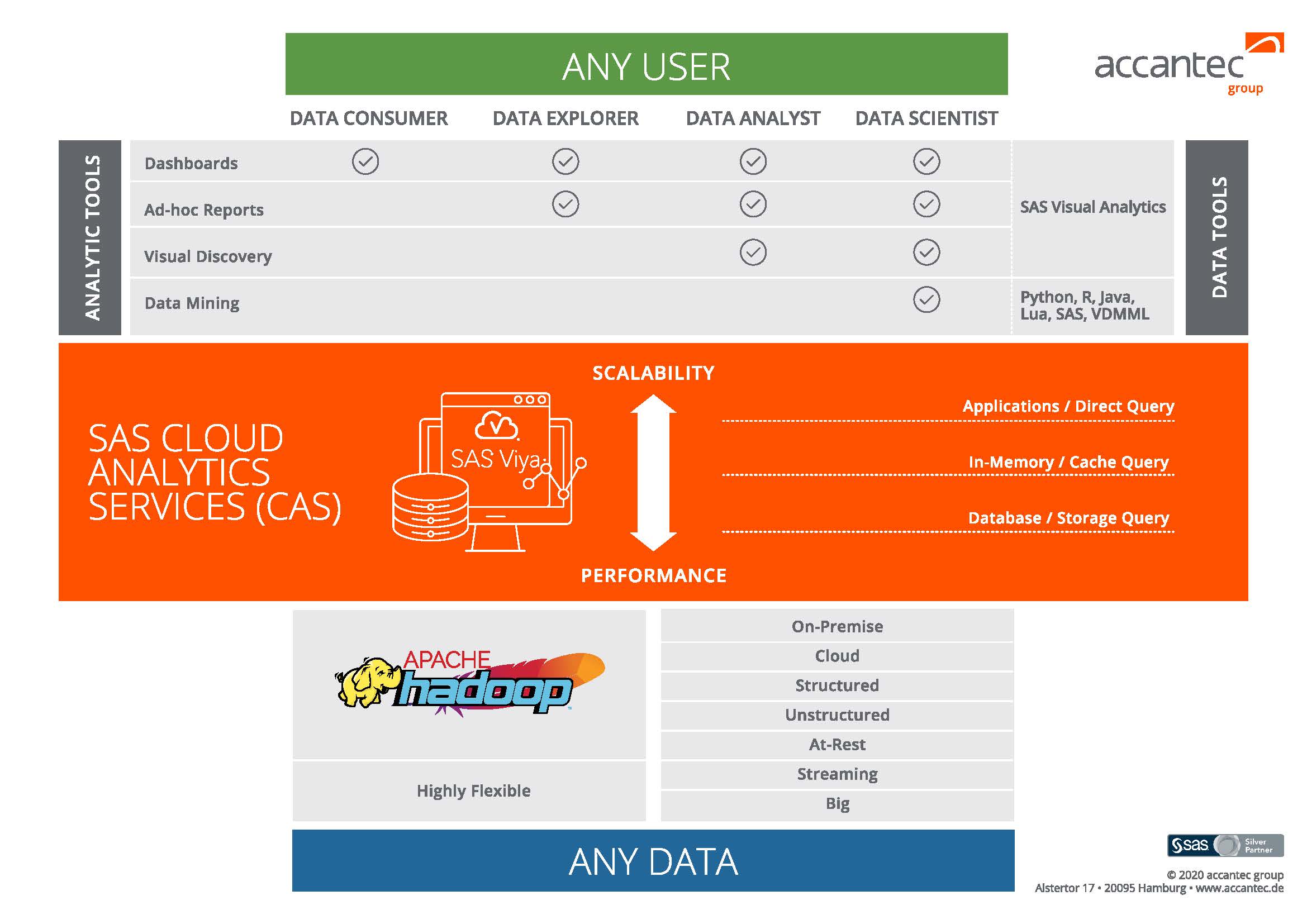

Im Gegensatz zu Apache Hadoop, bietet SAS mit SAS Viya einen kompletten Abenteuerspielplatz für agile IT-Umgebungen, ohne dass sich der User in technischen Details verliert. SAS Viya ist eine hoch performante, moderne Analytics-Plattform, die speziell dafür konzipiert ist, neue Erkenntnisse aus einer Vielzahl von Daten zu generieren. Die skalierbare Full-Stack-Plattform besteht aus dem SAS-Server CAS (SAS Cloud Analytics Services) und diversen Diensten, die mit dem CAS interagieren. Somit umfasst SAS Viya alle notwendigen Komponenten von der Administration, über das Datenmanagement bis hin zum Scheduling und Back-Ups.

SAS Viya gibt Data Scientists mit seinem Werkzeugkasten interessante Instrumente in die Hand, um Datenanalysen mit gewohnten „Boardmitteln“ unkompliziert über die SAS Analytics Plattform abzuwickeln.

Mithilfe der zusätzlichen Softwarekomponente SAS Visual Data Mining and Machine Learning (VDMML) werden die Datenaufbereitung und -Exploration mit modernen Data Mining und Deep Learning Methoden in SAS Viya kombiniert. In dieser Konstellation verfügt der User über ein breites Spektrum an möglichen Quellsystemen, Programmiersprachen, Entwicklungsumgebungen und analytischen Methoden, die SAS Viya von Haus aus mitbringt und keine weitere Installation erfordern. Darunter befinden sich neben den typischen SAS Komponenten auch Open-Source-Lösungen wie Python, R, Jupyter und GitHub. Die Skriptsprache CAS Language (CASL), mit der sich Aktionen direkt auf dem CAS ausführen lassen, ist flexibel über die gewohnten Programmiersprachen wie Python, R und Lua abrufbar.

Selbstverständlich bleibt mit SAS Viya die Möglichkeit erhalten, mithilfe von SAS Code Funktionen zu erweitern bzw. zu implementieren. Dieser Offenheit ist es zu verdanken, dass SAS Viya eine Vielzahl an Möglichkeiten für Data Scientists bereithält. Auf der anderen Seite muss man als SAS Viya User kein Data Scientist sein, auch Business Analysten sowie Anwendungsentwickler und Führungskräfte profitieren von den Möglichkeiten in SAS Viya. So sind z.B. für die integrierten Machine Learning Algorithmen lediglich statistische Grundkenntnisse für die Beurteilung, welche Algorithmen sich für die Auswertung der jeweiligen Daten eignen, erforderlich. Als Nutzer kann man somit per Point-and-Click schnell und einfach Neuronale Netze und andere Deep Learning Algorithmen ausführen.

Selbstverständlich helfen die IT-Experten der accantec consulting AG gern bei der Konzeption, Implementierung, dem Test und finalen Rollout sowie der Erweiterung der bestehenden Architektur und Funktionalitäten, unabhängig von der Business Unit: www.accantec.de