Anknüpfend an meinen Einstieg in die Big-Data-Welt und nach meiner Reise in die Vergangenheit mit „In-Memory“ hat mich die Neugier gepackt. Was hat es mit anderen Technologien auf sich, die gerade dabei sind, unsere Welt zu revolutionieren? Blicken wir zunächst einmal auf „Event Stream Processing“ (ESP). Ein Thema, das gerade in aller Munde ist. Super Mario lässt grüßen.

Die Verarbeitung von Datenströmen in Echtzeit wird nahezu durchgängig als wahres Daten-„Eldorado“ gesehen, aus dem neue Geschäftsideen nur so sprudeln. Stream Processing gilt als absolute Schlüsseltechnologie, um das sogenannte „Internet der Dinge“ überhaupt beherrschbar zu machen. Aber das Ganze ausschließlich im Hinblick auf die Datenerfassung zu betrachten, wäre nur die halbe Wahrheit. Denn Datenerfassung in Echtzeit ohne entsprechende Datenverwertung in Echtzeit macht keinen Sinn. Deshalb gewinnen gleichzeitig auch moderne Datenvisualisierungstechniken zunehmend an Bedeutung, da diese neue Informationsflut mit klassischen Mitteln wie Kreuztabellen nicht mehr effektiv dargestellt werden kann.

Daten, die in „Realtime“ verarbeitet werden, müssen letztendlich auch in „Realtime“ vom Anwender interpretiert werden können, denn vieles, aber nicht alles kann automatisiert im Hintergrund erfolgen. Dafür braucht man Methoden und Instrumente, die flexibel, schnell und aussagekräftig genug für Big-Data-Strukturen sind.

Und auch hier haben die 1980er-Jahre (wie bei meiner „In-Memory“-Recherche) eine der innovativsten und spannendsten Big-Data-Applikationen aller Zeiten hervorgebracht. Eine Applikation, die ich liebe, und die noch dazu ein riesiger finanzieller Erfolg war.

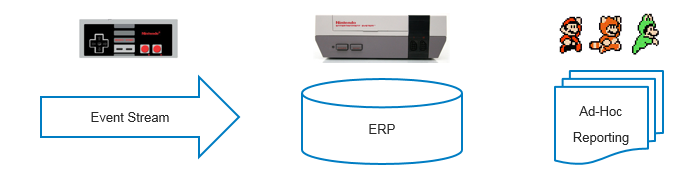

Die Realtime-Event-Stream-Visualisierungsapplikation, von der ich spreche, nennt sich „Super Mario“ und wurde von der Firma Nintendo für die Spielkonsole „NES“ im Jahr 1985 veröffentlicht.

O.K., ich gebe es zu: Der Zusammenhang zwischen Super Mario und Big Data erschließt sich einem nicht auf den ersten Blick. Doch gehen wir den Big Data Use Case „Super Mario“ anhand der Anforderungen einmal gemeinsam durch:

Datenhaltung In-Memory: Die Spielkonsole hatte damals aus Kostengründen keinen persistenten Speicher, was dazu führte, dass man keine Spielstände abspeichern konnte (der erfahrene Spieler erinnert sich bestimmt). Man musste die Spiele also immer von Beginn an durchspielen. Die einzige Möglichkeit, auf einem höheren Level zu starten, waren Shortcuts (durch Eingeben von Codes oder Ähnlichem). Das bedeutete für die Applikation aber auch, dass sämtliche Daten In-Memory gehalten und verarbeitet werden mussten.

Benutzerfreundlichkeit: Eine intuitive und leicht bedienbare Oberfläche war ein absolutes Muss, da die größte Zielgruppe Kinder – und jung gebliebene Erwachsene – waren. Die Bedienungsanleitung musste, sofern überhaupt notwendig, auf ein kleines Blatt Papier passen, sonst war eine Anwendung zum Scheitern verurteilt. Man kann auch durchaus von „Self-Service“ sprechen, da der Spieler zugleich Endanwender und Administrator war.

Datenströme (Events) in Echtzeit verarbeiten: Zugegeben, es waren keine Massendaten, die hier zur Verarbeitung hereinströmten – jeder Spieler hat ja nur zwei Daumen … aber unstrukturiert und zum Teil völlig willkürlich in jedem Fall! Und wenn man bedenkt, dass bis zu vier Spieler gleichzeitig auf Teufel komm raus wild auf die Controller eintrommeln, dann kann da in einer Stunde doch sehr viel an Datenmaterial erzeugt werden, das man erst einmal rechtzeitig in die richtigen Anweisungen umwandeln und dann wieder am Bildschirm ausgeben muss.

Datenvisualisierung: Also in diesem Punkt kann es meiner Ansicht nach keine zwei Meinungen geben: Mit Sicherheit ist die Visualisierungstechnik das Prunkstück und eine der Kernkomponenten von Super Mario. Ich persönlich habe noch keinen Unternehmensbericht gesehen, der es damit auch nur ansatzweise aufnehmen konnte.

Stellvertretend möchte ich aber doch zwei Techniken herauspicken, die auch heute eine große Rolle in modernen Dashboards spielen: bedingte Formatierung und Animation. In „Super Mario“ ist natürlich alles animiert, eine Technik, die heute mehr und mehr auch in Geschäftsberichten Anwendung findet. Animation hilft, Muster besser und schneller erkennen zu können und dadurch frühzeitig auf neue Entwicklungen zu reagieren. Absolut „überlebensnotwendig“ in der Welt von Super Mario – und auch in der Geschäftswelt von immenser Bedeutung!

Und bedingte Formatierung (zum Beispiel in Form einer Ampelgrafik) findet sich ebenfalls in beiden Welten wieder. In Geschäftsberichten, um schnell und einfach den Status von bestimmten Entitäten aufzuzeigen, bei Super Mario vor allem, um den allgemeinen Gesundheitszustand der Spielfiguren zu beschreiben (siehe Bild).

Wie bei „In-Memory“ tauchten also auch bei „Realtime“, „Event Stream Processing“ und „Visualisierung“ einzelne Techniken und Methoden nicht erst mit dem Big-Data-Hype auf, sondern sind schon seit Jahrzehnten am Markt.

Wir sind demnach mit unseren aktuellen Herausforderungen nicht allein, und es gibt durchaus schon Erfolgsgeschichten, die mit diesen Technologien geschrieben wurden. Und die Erfolgsgeschichte war meist dann am größten, wenn der Einsatz einer Technologie mit einer cleveren Methodologie kombiniert wurde – also Analytik, der Kernkompetenz von SAS.

Das ging den Entwicklern von Nintendo damals nicht anders, denn Super Mario musste erst einmal eine gewaltige technische Hürde überspringen, bevor er sich das erste Mal auf die Suche nach der Prinzessin machen konnte. Die ersten Versionen brauchten trotz sparsamsten Umgangs mit den Ressourcen immer noch das Achtfache des verfügbaren Arbeitsspeichers.

Wie konnte man dieses Ressourcen-Problem lösen? Unsere Experten wissen es …

Und wie ist heute der Stand in Sachen Analytics und Big Data? Das zeigen anschaulich die SAS Foren – am 28. April in Bonn und am 1. Juni in Zürich.

1 Comment

That's a smart answer to a diiucfflt question.