Aus ihren Daten wirklich Nutzen zu ziehen, können viele Unternehmen. Das Finden von Mustern mit Data Mining gibt es seit Jahrzehnten, eine ähnliche Historie weisen Forecasting oder Predictive Analytics auf. Je nach Datenart und Anforderung gibt es hier schon sehr lange valide, reliable und vor allem alltags- sowie business-relevante Methoden – denken wir nur an so alltägliche Bereiche wie Wettervorhersagen und Stauprognosen.

Wenn ich aber sage „Unternehmen“ können dies, muss man ehrlicherweise hinzufügen, dass damit in der Realität vereinzelte Experten in spezialisierten Abteilungen gemeint sind, die zum allergrößten Teil eine mathematische oder sogar statistische Ausbildung, meist ein Studium, mitbringen. Das liegt in der Natur der Sache: Sobald man sich über Intuition und gefühlte Realität („Bei Ferienbeginn staut es sich am Brenner“ oder „im Sommer wird mehr Eis verkauft“) hinaus begibt, geht es eben um die Entwicklung von Vorhersagemodellen mit mathematischen Algorithmen. In der wissenschaftlichen Diskussion ist das disziplinübergreifend akzeptiert: Ohne mathematische Kenntnisse sind alle empirischen Wissenschaften von Maschinenbau bis zu den Sozialwissenschaften nicht denkbar. Nicht umsonst gehört ein Statistik-Grundkurs mittlerweile in die Lehrpläne vieler Studiengänge. Aber auch in den Unternehmen setzt sich diese Erkenntnis immer mehr durch.

Mathematik - die Grundlage für wirtschaftlichen Erfolg?

Eine stetig fortschreitende Rationalisierung des Wirtschaftslebens hat dafür gesorgt, dass jegliche Entscheidungen in ihren Auswirkungen nicht nur auf Fakten basieren sollten, sondern dies eben auch können. Anders gesagt: die Voraussetzungen für eine Mathematisierung der Unternehmensführung sind durch die massenhafte Verbreitung entsprechender Technologien geschaffen. Die Überlegung ist einfach: Nur was gemessen werden kann, kann auch gemanagt werden (Peter Drucker). Und je mehr ich messen kann, desto mehr kann ich managen und damit womöglich einen Wettbewerbsvorsprung erarbeiten.

Das führt ganz zwangsläufig dazu, dass immer mehr Messdaten erhoben werden: Wie viele Produkte habe ich in welchem Verkaufskanal zu welchem Preis verkauft? Welche Produkte bietet mein Wettbewerber an? Welche Kunden sind für mich profitabel? Diese Fragen sind heute beantwortbar – und liefern die Grundlage für die oben genannten „Unternehmen“, die heute Vorhersagen, Data-Mining und Predictive Analytics einsetzen.

Damit hat sich aber eine Lücke aufgetan: Die Fragen bezüglich den Messpunkten und den möglichen Ableitungen für die Zukunft nähren sich aus den Herausforderungen des jeweiligen Unternehmens und des jeweiligen Geschäftsmodells. Dazu ist tiefes Fachwissen erforderlich, ob es um Bereiche wie Produktionsoptimierung, Vertrieb- und Marketing oder logistische Fragestellungen geht. Die gut ausgebildeten Mitarbeiter in diesen Fachbereichen bringen aber nur ein Grundgerüst an mathematischen Kenntnissen mit, keineswegs die „High-End“-Anforderungen, die an die Entwicklung von Vorhersagemodellen, neuronalen Netzen und anderen, mittlerweile gängigen Verfahren gestellt werden.

Und wenn die Frage zur Antwort kommt - anstatt immer den Berg zum Propheten zu schicken?

Wie wäre es nun aber, wenn die Antworten dort gefunden werden könnten, wo auch die Fragen gestellt werden? Und damit die Entwicklung neuer Fragen gefördert und ermöglicht wird? Das zu ermöglichen ist die alles entscheidende Triebfeder in der aktuellen Big-Data-Diskussion. Wie schaffen es Unternehmen, die Nutzung von fortgeschrittenen mathematischen Verfahren zu verbreitern und damit neue Effizienzen in ihren Kernprozessen zu heben. Die Mathematik ist nicht einfacher zu machen, als sie ist. Die Daten sind so, wie sie sind. Und auch die Menschen sind so, wie sie sind. Zu glauben, man könne jetzt einfach überall „Data Scientists“ einstellen, ist naiv – diese Leute gibt es nicht in ausreichender Zahl.

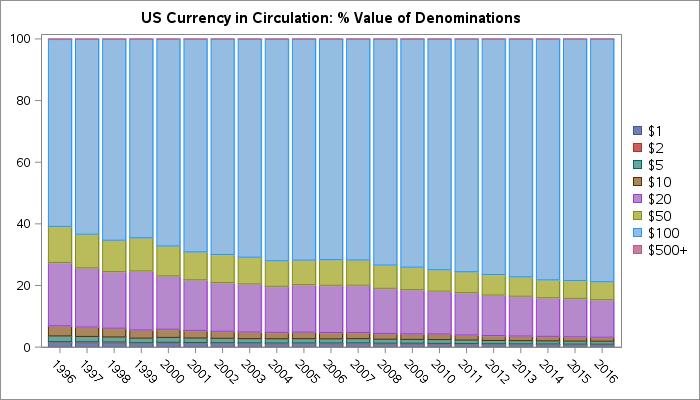

Der Weg muss ganz klar dahin gehen, die Nutzung von Analytics so einfach wie die Bedienung von Outlook und Powerpoint zu machen. Diesen Weg geht nicht ganz überraschend einer der Pioniere der Statistik unter zu Hilfenahme neuester Technologien – mit SAS Visual Analytics. Die Visualisierungen machen Bedienung, Exploration und Verständnis der Ergebnisse um ein Vielfaches leichter – und damit Analytics erstmals wirklich greifbar für den Fachbereich. Der ausgebildete Statistiker wird dort vieles vermissen und trotzdem die Qualität der Ergebnisse mit seinen eigenen vergleichen können. Aber für viele Mitarbeiter in vielen Unternehmen ist das eine ganz große Chance, faktenbasierte Entscheidungen auf eine neue Qualitätsebene zu heben. Ich würde sagen „Self-Service-Business Analytics“ (nicht nur Self-Service-BI) ist der Schlüssel, für den Nutzen von Daten, meinetwegen auch von Big Data.

Wie Unternehmen visuelle Analysen nutzen und welche Erfahrungen bereits heute mit Self-Service-Ansätzen gemacht wurden, erfahren Sie auch auf dem SAS Forum 2013 am 11. und 12. September 2013 in Mannheim.

1 Comment

SAS Visual Analytics ist ein ausgezeichnetes und einfaches System; ergonomisch, schnell, leicht...Technisch im Hintergrund anspruchsvoll und leistungsfähig.

Das alles darf aber trotzdem nicht darüber hinwegtäuschen, dass Ergebnisse einer Datenbank und eines Frontends nur dann überhaupt verwertbar sind, wenn sinnvolle und "richtige" Quelldaten zur Verfügung stehen.

Nach wie vor bleibt es wichtig, die Daten selbst, deren Erhebung sowie deren Qualität in höchstem Maße zu berücksichtigen; denn mehr Daten bedeutet nicht auch gleichzeitig mehr Qualität im Analyseergebnis. Eher steigt die Gefahr einer Fehlinterpretation, wenn Quelldaten fehlerhaft sind oder einen völlig anderen Kontext haben.

Aus diesem Grund wird der Bedarf für entsprechende Fachleute immer hoch bleiben, die neuen Werkzeuge machen aber das Verbreiten und "Sprechen" der Ergebnisse für Berichtsempfänger und Entscheider leichter. Daher - meine Meinung - sind diese neuen hervorragenden Systeme keine "Bedrohung" für Mathematiker, Controller und Statistiker. Nein, sie sind vielmehr ein Sprachrohr, oder um im BI-Jargon zu bleiben: Self-Service-BI.