Echtzeit? Den Algo-Tradern wird das jetzt ein Lächeln auf die Lippen zaubern. Natürlich rede ich in diesem Zusammenhang nicht über Milli- oder Mikrosekunden, aber über Antwortzeiten die für einen Fachanwender akzeptabel sind, um interaktiv mit einer analytischen Applikation zu arbeiten.

In diesem Fall darf sich nämlich eine solche Anwendung schon einmal einige Sekunden Zeit lassen: Bei der Dimensionierung der Hardware peilen wir üblicherweise eine Antwortzeit von maximal 10 Sekunden an. Die meisten Operationen sind natürlich trotzdem schneller und erlauben so ein flüssiges Arbeiten auch mit sehr großen Datenmengen. Und da ist er wieder, der Begriff Big Data. Natürlich werden die Datenmengen immer größer, volatiler und unstrukturierter. Ein Trend den wir schon eine Weile beobachten (Hype um Big Data hin oder her). Umso wichtiger ist eine Architektur, die mit den Daten mit wachsen kann!

Eine „Scale-up“ Architektur (also wenn der Server mal wieder platzt oder die Prozesse zu lange dauern, den Server in Rente schicken und einen neuen, größeren und schnelleren kaufen) ist aus mehreren Gründen eher suboptimal. Zum einen wird es ab einer gewissen Grenze unverhältnismäßig teuer, zum anderen gibt es auch gewisse Grenzen z.B. beim Hauptspeicher oder der Anzahl Prozessorkerne. Von dem Aufwand für eine Migration auf eine neue Umgebung will ich gar nicht reden.

Die Lösung heißt hier: „Scale-out“, d.h. anstatt die existierende Hardware auszumustern, stelle ich einfach neue Server neben die existierenden. Also viele kleine statt eines großen Servers. Mit einer solchen Architektur kann ich klein einsteigen, bin aber völlig unbeschränkt in meinem Wachstum und kann sowohl Hauptspeicher als auch Prozessorleistung praktisch beliebig ausbauen. Firmen wie Google oder Facebook zeigen, was da möglich ist.

Das Konzept die Daten und die Arbeitslast auf einen Rechnerverbund (Cluster) zu verteilen ist nichts revolutionär neues. Allerdings braucht es natürlich auch die passende Software, die in der Lage ist, verteilt zu rechnen. Auf den Hochleistungsrechnern und Supercomputern rund um den Globus laufen meist sehr spezielle Applikationen die z.B. zur Wettervorhersage oder für komplexe Simulationen verwendet werden. Ohne die zugehörigen Wissenschaftler und Experten auf dem jeweiligen Gebiet (oftmals Universitäre Forschung) sind diese Rechenmonster praktisch nutzlos. Erst seit wenigen Jahren entwickelt sich auch ein Markt für Standard Software, die in der Lage ist, auf Clustern zu rechnen. Google hat hierfür eigens Map Reduce und ein verteiltes Filesystem entwickelt, auf dem auch Apache Hadoop und viele andere Open Source Frameworks basieren.

Für das verteilte Rechnen von Analytischen Funktionen (also alles was über Durschnittswerte und simple Aggregationen hinausgeht) bedarf es einiges an Know-how! Zum Glück hat SAS als Marktführer in diesem Bereich genau die richtigen Entwickler zur Hand. Im Headquarter in Cary (NC) entstand so in den letzten Jahren eine technologische Basis, die seiner Zeit weit voraus ist. Unter dem Begriff „High Performance Analytics“ verbergen sich all die Grundlagen, um analytische Applikationen zu bauen, die praktisch beliebig skalieren und somit von klein bis riesig alles abdecken.

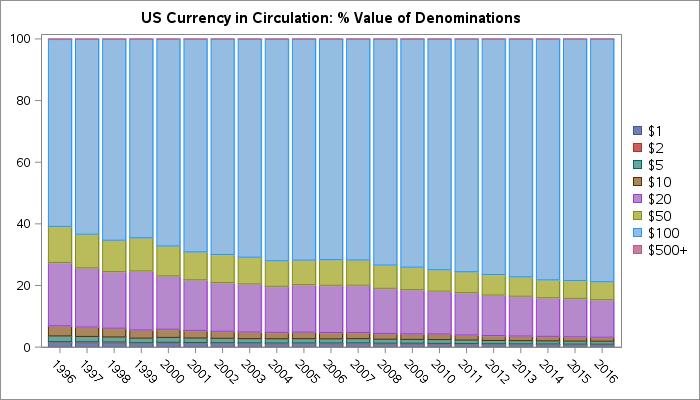

Wenn man nun das verteilte Rechnen noch mit In-Memory Technologie vereint, erlaubt das ganz neue Anwendungen, die bisher schlicht nicht möglich waren, da die Rechendauer für Interaktivität deutlich zu groß war oder sehr stark von der Datenmenge abhing. SAS Visual Analytics ist nur ein Beispiel, wie man die Basis, die SAS in den letzten Jahren geschaffen hat, für neue und innovative Technologien nutzen kann und diese einer breiten Masse zur Verfügung stellen kann.

Die Hürde zum Einstieg in Business Analytics ist dramatisch gesunken. Sprechen Sie uns an, wir zeigen Ihnen gerne wie so etwas im Detail aussehen kann.

1 Comment

Klar, das verteilte Rechnen ist nicht neu; aber das war viele Jahre nur den ganz großen Unternehmen und Budgets vorbehalten, jetzt ermöglichen neue Technologien und Ansätze den breitflächigen Einsatz auch im Mittelstand. Und eine weitere Hürde fällt: auch Laien können diese neuen Systeme wie SAS Visual Analytics bedienen.