Seien Sie unbesorgt! Es folgt kein Auszug aus einem romantischen Liebesbrief. Die Überschrift zu diesem Blogbeitrag ist vielmehr eine Anspielung auf meinen Vortrag über „Fehlende Werte“, also Miss. Values, auf der A2013 Konferenz, die vom 19. bis 20. Juni in London stattfindet.

Keine Zeit für Gefühle: Die Auseinandersetzung mit fehlenden Werten in der Analytik ist nicht etwa ein romantisches Spiel, sondern notwendige Realität für viele Statistiker und Data Miner. Ein Grund mehr also diesem Thema die entsprechende Aufmerksamkeit zu widmen. In diesem Beitrag möchte ich exklusiv für Sie ein paar meiner Gedanken über fehlende Werte mit Ihnen teilen und Ihnen schon jetzt einen Vorgeschmack auf meinen Vortrag geben.

Dabei muss man aber differenziert vorgehen: Fehlende Werte und fehlende Werte sind leider nicht immer das gleiche. Es wäre vermutlich auch das erste Mal, dass es in der Statistik ein Generalrezept für etwas gäbe. Die genaue Betrachtung der Eigenschaften von fehlenden Werten ist aber unumgänglich, um die richtigen Rezepte zur Erkennung und Behandlung zur Hand zu haben.

Wie erkenne ich, dass etwas fehlt?

Diese Frage klingt trivial. Einen fehlenden Wert erkennt man daran, dass in der Tabellen-Zelle ein Feld nicht befüllt, sondern leer ist! In der Tat gibt es viele Beispiele solch expliziter fehlender Werte. Beispielsweise bleibt ein Feld leer, weil das Geburtsdatum nicht bekannt ist. Oder ein Kunde verweigert die Bekanntgabe und so wurde im Feld „Anzahl Kinder“ kein Wert eingetragen. Fälle wie diese können durch Datenbankabfragen einfach entdeckt und selektiert werden.

Aber nicht alle fehlenden Werte offenbaren sich uns aber so deutlich! Die Auswertung der Anzahl der Maschinenstillstände in einer Fabrik liefert beispielsweise folgende Ergebnisse: drei Ausfälle im April, vier im Mai 2013, zwei im Juli. Aus rein datentechnischer Sicht haben wir hier keinen fehlenden Wert. Das Feld „Anzahl Ausfälle“ ist immer befüllt. Aus inhaltlicher Sicht haben wir aber sehr wohl fehlende Daten: Wir haben keinen Eintrag für den Juni. Es ist nun zu entscheiden, ob dies bedeutet, dass im Juni keine Ausfälle waren, oder ob für den Juni keine Aufzeichnungen existieren.

Somit ist bei der Analyse hier

1.) zu prüfen, wo Datenpunkte fehlen, d.h. die Zeitreihe „Löcher“ hat und

2.) zu entschieden, wie diese zu interpretieren ist.

Im Beispiel mit den Monaten können wir die Lücke entdecken, weil wir den Kalender kennen und wissen, dass nach dem Mai der Juni kommen muss. Wenn wir hingegen analysieren wollen, wie viele und welche Produkte ein Versicherungskunde hat und die Daten aus einem Bestandssystem (z.B. der Krankenversicherung) nicht bereitgestellt werden, so sieht die Situation anders aus. Dann haben wir fehlende Informationen ohne dass diese explizit einfach sichtbar sind. In diesem Fall ist eine Durchsicht der Daten und der ersten Aggregationen mit einem Fachexperten sehr wichtig.

Genügen einfache Häufigkeiten wirklich?

Fehlende Werte werden oft beschrieben indem ihre Häufigkeit pro Merkmal im gesamten Bestand ermittelt wird. Dies resultiert dann beispielsweise in folgenden Analysen: Einkommen in 12 % fehlend, Alter in 8 % fehlend, Änderungsdatum in 4 % fehlend.

So lässt sich ein einfaches Bild zeichnen, welche Merkmale am häufigsten von der „Missing-Value Krankheit“ befallen sind. Wir erkennen aus dieser Analyse aber nicht, bei wie vielen Zeilen in der Tabelle kein einziges Merkmal fehlt. Genau das, nämlich die Anzahl der sog. „Full-Records“, ist aber für viele statistische Analysen eine wichtige Kenngröße. Im obigen Beispiel können dies 88 % der Zeilen sein, wenn die Werte bei Alter und Änderungsdatum nur fehlen, wenn auch der Wert im Feld Einkommen fehlt. Es können aber auch nur 76 % der Zeilen sein, wenn sich das Fehlen der Angaben beliebiger verteilt.

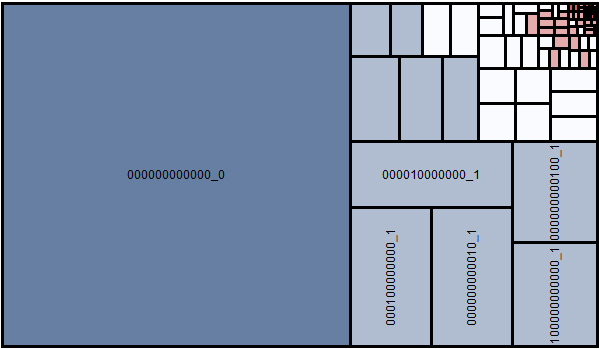

Eine häufige angewandte Methode zur Erkennung der Struktur der fehlenden Werte ist die Analyse der „Missing Value Patterns“ und die Darstellung in Form von Kacheldiagrammen. Hier kann auf einem Blick erkannt werden, dass etwa 60 % der Records keinen einzigen fehlenden Wert haben (Pattern 000000000000) und dass weitere 30 % der Records nur bei einem Merkmal einen fehlenden Wert haben (hellblau). Die kleinen roten Zellen zeigen Gruppen von Records, wo bereits 5 oder mehr Merkmale fehlen. Diese Information ist für die Entscheidung wichtig, ob fehlende Werte durch analytische Methoden imputiert (ersetzt) werden können.

Alles nur Zufall?

Die rein mengenmäßige Betrachtung von fehlenden Werten gibt aber noch kein vollständiges Bild. Vielmehr ist die Analyse und Entscheidung über das zufällige oder systematische Auftreten entscheidend.

Fehlende Altersangaben, die zufällig bei 20 % der Kunden vorkommen, sind zwar ein Informationsverlust und erzeugen eine gewisse Unschärfe in unseren Daten. Wir können aber davon ausgehen, dass wir zwar „unschärfer sehen“, aber dies für alle Segmente, Regionen, … gleich häufig auftritt und unser Blick somit “nicht verzerrt wird“.

Fehlen die Werte hingegen bei jenen Kunden, die schon lange eine Vertragsbeziehung mit unserem Unternehmen haben (Vielleicht wurden Neukunden früher nicht nach dem Geburtsdatum gefragt?), so müssen wir uns der Tatsache bewusst sein, dass „Alter unbekannt“ nicht nur mit der Dauer der Kundenbeziehung, sondern auch mit dem Alter selbst (wird bei älteren Kunden häufiger fehlen) und potentiell mit andere Eigenschaften (Region, Produkttyp, …) korreliert ist. Dies muss für die Analyse auch berücksichtigt werden.

Für diese Fälle bieten analytische Methoden gepaart mit fachlichem Verständnis mächtige Verfahren zur Erkennung und Behandlung systematischer fehlender Werte, die über die simple „Ich-setze-den-Mittelwert-für-fehlende-Werte-ein“-Methode hinausgehen und eine bessere Analysebasis schaffen.

Interesse geweckt?

Wenn diese Zeilen Ihr Interesse geweckt haben, freue ich mich, Sie bei einem meiner nächsten Vorträge, beispielsweise am 12. Juni am SAS Data Mining Anwendertag in Heidelberg oder am 19. und 20. Juni auf der A2013 in London in meinem Vortrag begrüßen zu dürfen. Falls Ihnen das zu lange zum Warten ist, können Sie in meinem neuen Buch „Data Quality for Analytics Using SAS“ (http://www.sascommunity.org/wiki/Data_Quality_for_Analytics) schon „vorlesen“.

2 Comments

Sehr interessant; wir sprechen (zu) oft über Daten, die da sind; und (zu) wenig über die, die NICHT da sind! Dabei ist ja gerade Letzteres der eigentliche Punkt in jedem Analytics Projekt.

Das Problem der "fehlenden" Daten fällt sicher auch in den Bereich des Datenqualitätsmanagements; was nicht da ist, kann zwar nicht falsch sein, aber zu falschen Ergebnissen führen.

Vollkommen richtig! Das ist der Bereich, wo Datenverfügbarkeit und Datenvollständigkeit aneinanderstoßen.

Und man ist hier auch sehr schnell bei Überlegungen wie "Relevanz von Daten", "technische vs. fachliche Datenqualität".

Daten können technisch gesehen, sehr gute Datenqualität haben, aus fachlicher Sicht trotzdem wenig Wert haben. Der Tatsache, dass Daten in einem System gespeichert sind, geht oft eine fachliche Notwendigkeit für deren Speicherung voraus. So kann es oft sein, dass das was wir in Bits&Bytes in den Tabellen vorfinden stark vom Datenerfassungsprozess und Charakteristika der ursprünglichen Fragestellungen beeinflusst sind. Durch die bloße Verfügbarkeit ist aber nicht sichergestellt, dass diese Daten auch für eine andere (ähnliche) Fragestellung geeignet sind.